西班牙用DALL-E生成老照片,正探索联用回忆疗法治疗痴呆症患者

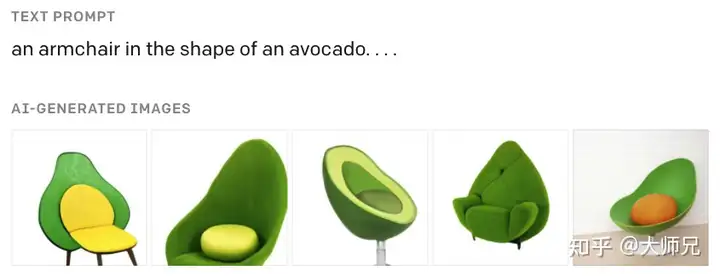

20 世纪 40 年代,玛丽亚在西班牙巴塞罗度过了一段童年时光。她对父亲的记忆仍历历在目。 六岁的时候,当玛丽亚想见父亲时,就会去同一栋楼里的邻居家。因为她可以透过那里的阳台栏杆看到下面的监狱,并通过牢房的小窗户瞥见父亲。她的父亲因反对当时的政府而被关在那里。 这段阳台上的记忆并没有照片,但现在玛丽亚可以获得相似的东西:一张“假照片”。在巴塞罗那 Domestic Data Streamers(DDS)设计工作室看来,这是“基于记忆的重建”,也就是重建真实照片可能捕捉到的、记忆中的那个场景。 假照片是模糊而扭曲的,但它们仍然可以让人瞬间穿越回记忆中的那个时刻。 “你很容易分辨出对记忆的还原是否准确,因为这是一种发自内心的反应。” DDS 工作室的创始人保罗·加西亚(Pau Garcia)说,“这种情况每次都会发生。人们的反应是,‘啊!是的!就是这样!’” (来源:DOMESTIC DATA STREAMERS) 目前,DDS 工作室运营的“合成记忆”项目,已经将数十人的记忆以这种方式转化为图片。该工作室使用了图像生成模型,如 OpenAI 的 DALL-E,将人们的记忆具象化。 自 2022 年以来,该工作室获得了联合国和谷歌的资助,一直在与世界各地的移民和难民社区合作,将那些从未被拍摄过的场景转化为图像,或为那些背井离乡的人重塑早已遗失的老照片。 现在,DDS 工作室正在接管巴塞罗那设计博物馆旁边的一座建筑,用合成图像记录人们对这座城市的记忆。加西亚说,任何人都可以参与,为不断壮大的档案贡献记忆。 合成记忆可能不仅仅是一种社会或文化努力。2024 年夏天,该工作室将开始与研究人员合作,研究其技术是否可以用于治疗痴呆症。 令人难忘的涂鸦 该项目的想法来自加西亚 2014 年的一次经历,当时他在希腊与一个组织合作,该组织正在重新安置叙利亚难民家庭。 一名妇女告诉他,她并不害怕成为难民,但她害怕她的子孙后代成为难民,因为他们可能会忘记自己的家族历史:他们在哪里购物,穿什么衣服,如何穿这些衣服。 加西亚让志愿者在这些家庭居住的大楼墙上涂鸦,画下这名妇女的记忆。“那些涂鸦很糟糕,但合成记忆的想法诞生了。”他说。 几年后,当加西亚看到图像生成模型可以做什么时,他想起了那些涂鸦:“这是我最先想到的事情。” (来源:DOMESTIC DATA STREAMERS) 加西亚和他的团队采用的流程很简单。他们与受访者坐下来,让后者回忆特定的场景或事件。一位提示工程师根据回忆为模型编写提示(prompt),从而生成图像。 他的团队已经建立了一套提示术语词汇表,这些词汇经过了验证,适用于唤起不同历史时期和不同地点的记忆。 但加西亚说,提示经常要反复调整:“你把生成的图像展示给受访者,他们可能会说,‘哦,椅子在另一边’或者‘是在晚上,而不是白天。’然后你要不断修改提示,直到它与受访者的记忆一致。” 到目前为止,DDS 工作室已经使用这项技术来保存各种移民社区的记忆,包括居住在巴西圣保罗的韩国、玻利维亚和阿根廷家庭。 同时,它还与巴塞罗那的一家养老院合作,研究这种记忆重建技术如何帮助老年人。 该团队与巴塞罗那的研究人员合作,进行了一项由...