终于来了,Midjourney V6 很强大

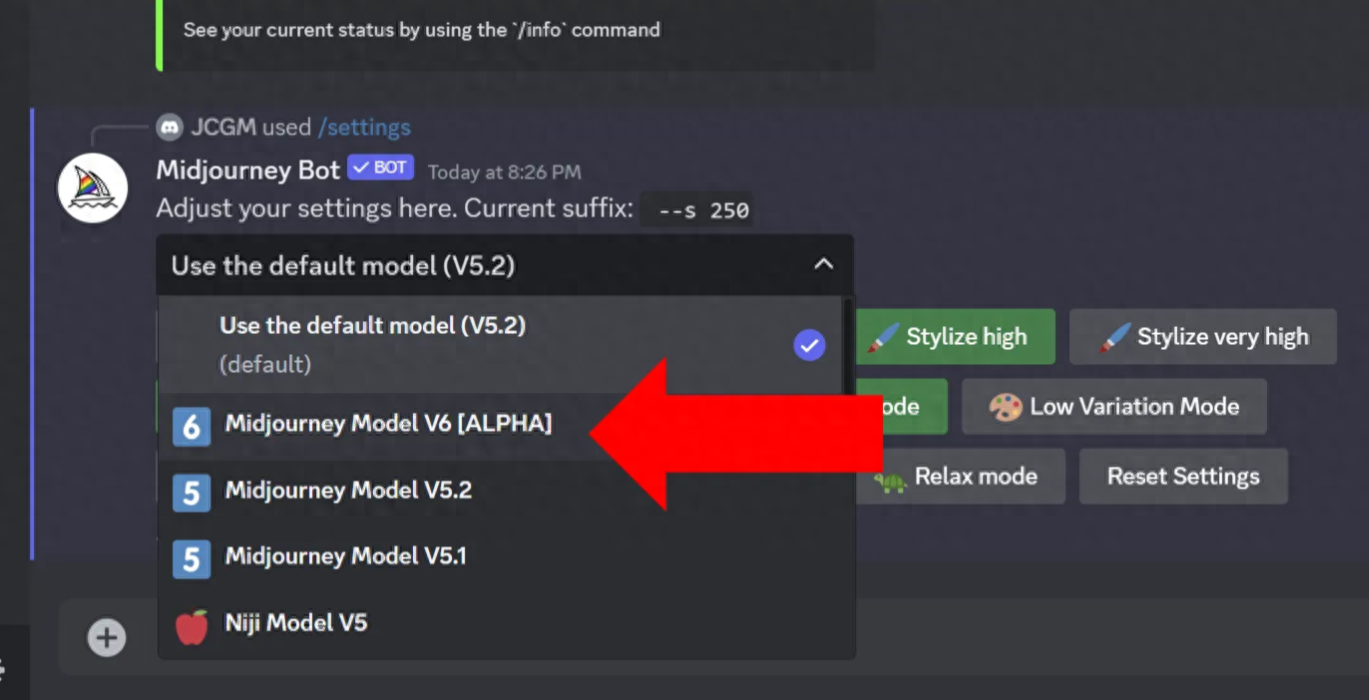

我们一直在等待的时刻终于来了——Midjourney V6来了!作为这个极其强大的人工智能艺术生成的长期粉丝,当 David Holz 在圣诞节前宣布发布 alpha 版本时,大家都很开心。 MidjourneyV6有什么新功能? V6可以更准确地理解提示V6 可以遵循更长的提示提高一致性和模型知识改进的图像提示和重新混合文字绘制能力较弱(必须将文字写在“引文”中)改进的升级器,具有“微妙”和“创意”模式(分辨率提高 2 倍) 如何激活MidjourneyV6 前往Discord上的 Midjourney 服务器。 打开 Midjourney 聊天实例并键入/settings以调出设置菜单。在默认模型下拉列表中,选择“Midjourney Model V6 [ALPHA]”。您可以尝试其他设置,但我现在将它们保留为默认值。 接下来,输入imagine关键字,弹出提示框,您可以在其中描述要生成的图像。 这是以下提示的结果: 提示:一张 32 岁女性在丛林中的照片,她是一位崭露头角的自然资源保护主义者;运动型短卷发和温暖的微笑 — s 250 — v 6.0 人工智能将生成结果的四种变体。单击 U1 至 U4 按钮,选择您想要升级的版本。 在此示例中,我想放大第二张图像。这是最终结果: 这是更多示例照片 提示:成年女性的照片。你的美丽无与伦比 全新的“文本”功能 我想强调一下这个包括我在内的粉丝们一直在等待的全新功能——文本功能。尽管 Midjourney 团队称该功能是“次要的”,但我的初步测试证明它已经相当优秀了。 这是一个例子:...