文章主题:OpenAI Sora, AI领域, 文生视频, 热度发酵

本文来自微信公众号:智东西(ID:zhidxcom),作者:程茜、ZeR0,编辑:心缘,原文标题:《Sora爆火48小时:杨立昆揭秘论文,参数量或仅30亿》,题图来自:视觉中国

OpenAI新爆款Sora的热度持续发酵,在科技圈的刷屏阵仗都快赶上正月初五迎财神了。

🌟【AI领域新星】OpenAI Sora引领热议🔥,马斯克等科技巨头竞相点评,杨立昆、贾扬清等业界大佬也不甘示弱,纷纷表示惊叹!👀影视营销人忧心忡忡,担忧这股创新浪潮将挑战传统职业。🚀这款大模型的横空出世,无疑为AI领域注入了强劲动力,未来趋势引人深思。欲了解更多,敬请关注!🏆

🌟【AI巨头热议】🚀OpenAI掌舵人萨姆·阿尔特曼在社交平台_X_上,与全球科技爱好者热烈互动,引发热议。马斯克的感慨:“人类对未知的探索,有时就像一场豪赌。”而360集团的大佬周鸿祎则预言:“AGI(通用人工智能)的到来,速度将超乎想象,可能只需短短1年!”🚀同样备受关注的AI领域新秀Runway的联合创始人兼CEO Cristóbal Valenzuela也不禁感叹:“这股科技洪流,让每一个参与者都心跳加速。”他的见解,无疑为行业注入了新的活力与期待。🌍尽管竞争激烈,但创新与合作始终是科技进步的主旋律。阿尔特曼和马斯克的互动,无疑展示了AI领域的开放态度和无限可能。让我们共同见证,这场科技革命如何改写未来!🌐

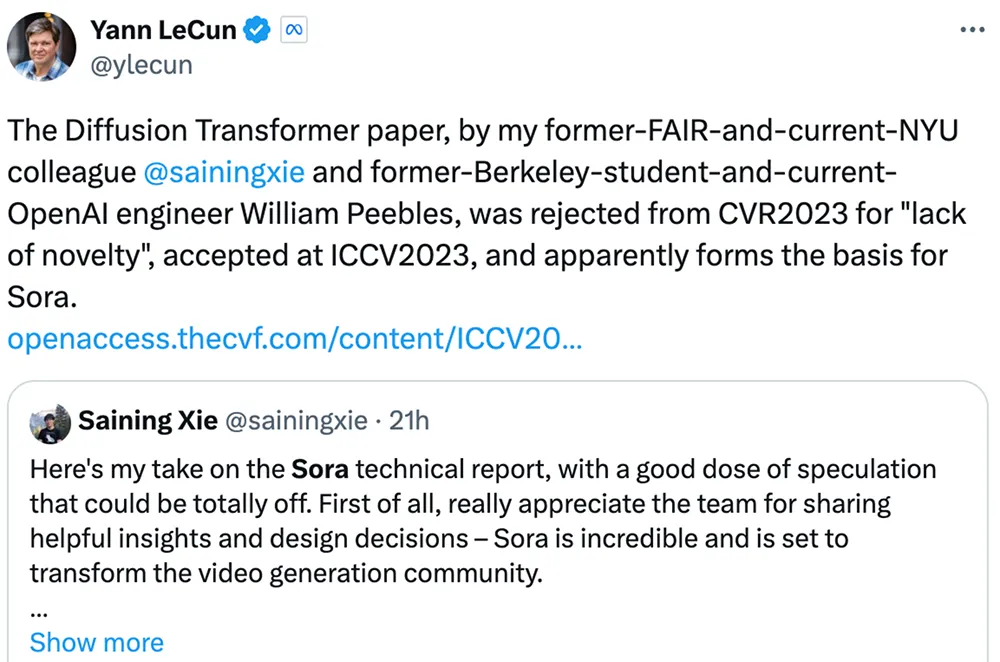

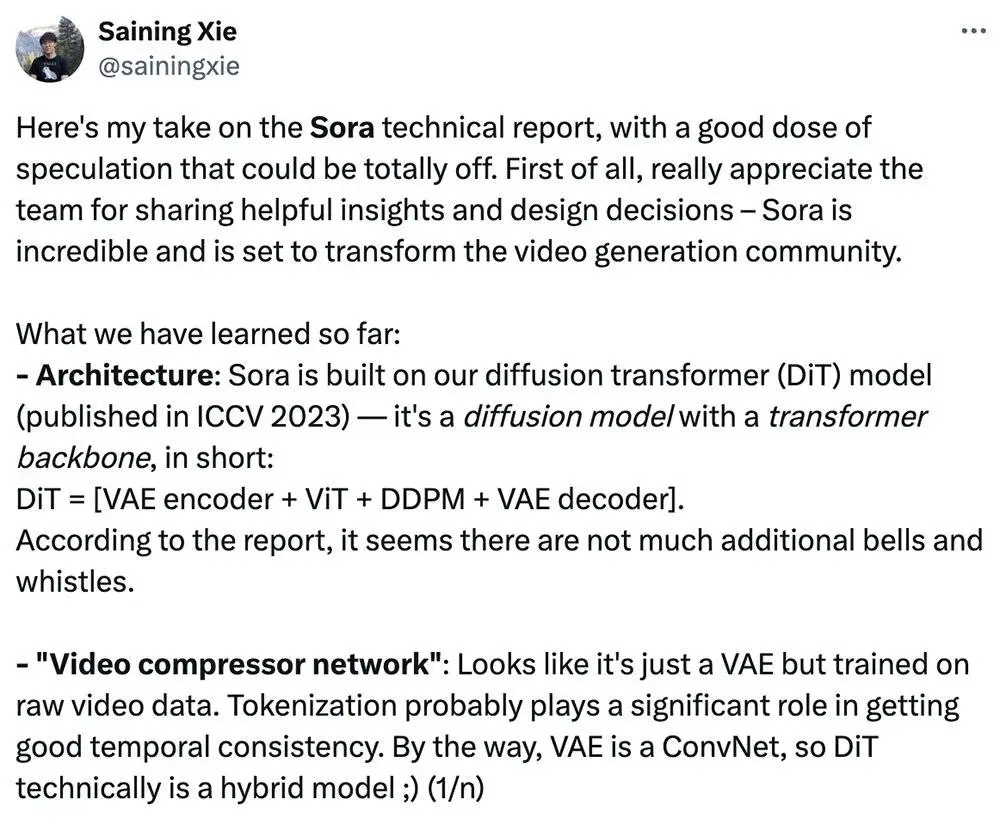

技术大牛们则开动脑力,从有限资料中抽丝剥茧,推演Sora的技术配方。Meta首席AI科学家杨立昆称,纽约大学助理教授谢赛宁作为一作的扩散Transformer论文是Sora的基础。谢赛宁也积极发长文分析Sora基于DiT架构、可能用到谷歌NaViT技术,推算Sora参数量约30亿。

🎨🚀OpenAI创新力量🔥——探索无限可能!👀瞧瞧这些令人惊叹的Sora生成视觉盛宴:🌊冲浪者与海洋的激情碰撞,👨🤝👨致敬传奇猫王的深情瞬间,还有那惊心动魄的鲨鱼跃出海面,直击海滩游客的心弦!每一帧都蕴含着科技与艺术的完美融合,展现了未来可能的模样。💡探索更多,敬请关注我们的最新动态,一起见证人工智能的无限创意!🎉—🎨🚀OpenAI技术新作,带你领略未来奇观!👀Sora的魔力已释放多款精彩视频:海上速度竞赛的激情燃烧,男士向巨星致敬的深深敬意,还有那震撼人心的鲨鱼瞬间,让海滩上的每个人都屏息凝神。每一段都闪烁着科技与艺术的独特火花,展示了人工智能无限可能的未来愿景。💡想要更多?请关注我们,第一时间获取创新动态,一起探索创意无界!🎉—🎨🚀OpenAI技术新作:Sora引领视觉革命!👀探索一系列令人震撼的视频作品——从海洋冒险到致敬巨星,再到鲨鱼惊魂,每一帧都展示了科技与艺术的交响曲。这些作品不仅展现了人工智能的力量,更传递了未来无限可能的信息。💡关注我们,获取最新动态,跟随创新的脚步,一起见证创意的璀璨!🎉—🎨🚀探索未来美学——OpenAI Sora视频新作揭示科技魅力!👀感受海洋自行车赛的狂野、男人对猫王的致敬与鲨鱼的惊人瞬间。这些作品是人工智能与艺术的结晶,每一帧都蕴含着创新与情感的力量。💡跟随我们的步伐,关注最新动态,解锁更多创意惊喜!🎉—🎨🚀OpenAI技术新作:Sora引领视觉革命,展现未来无限可能!👀探索一系列令人震撼的视频——从海洋冒险到致敬巨星,再到鲨鱼惊魂,这些作品是科技与艺术的完美结合。想要紧跟创新步伐?请关注我们,获取最新动态,一起见证创意的力量!🎉

🌟民间创新者们展现惊人技能:👀他们将OpenAI的生成视频示范中的关键词输入到诸如Midjourney、Pika、RunwayML等热门模型中,与这些行业领导者进行了一场无声的竞争,对比效果令人瞩目。🎨同时,一些先锋还巧妙地将Sora与谷歌Gemini 1.5 Pro这两款顶尖之作相结合,实现了动态的创新互动,这无疑是对技术前沿的一次精彩演绎。🌐他们的行动力和对新工具的熟练运用,不仅展示了超凡的创造力,也为未来的科技发展留下了深刻的印记。 若要了解更多这类令人惊叹的技术实践,不妨探索这些模型和项目,它们无疑是探索人工智能无限可能的重要窗口。记得关注SEO关键词:#民间高手# #技术创新# #AI互动

Sora的爆火,再度坐实了阿尔特曼“营销大师”的称号。

🚀💡针对某些网友对Altmann在Gemini 1.5发布后频繁活跃的质疑,我们不妨深入分析其背后的策略。他的行动看似无意中提升了这款技术突破的热点,却巧妙地避免了过度炒作。这更像是一个低调的技术引领者,用实际行动而非大张旗鼓的广告,悄然推动行业的发展。SEO优化提示:#Gemini1.5 #Altmann #技术引领

而最新被曝出的消息,似乎印证了OpenAI对新融资的迫切。据外媒报道,随着新一笔要约收购交易完成,OpenAI的估值或超过800亿美元。

🌟阿尔特曼的7万亿芯片野心急需资金支持🔍——近期已追加1万亿,引得特斯拉之父马斯克热议发声!🚀尽管目标宏伟,但每一步都需要稳健的资本注入才能稳步向前。让我们共同期待这位行业巨擘如何引领这场科技盛宴!🏆

这样看来,利好的还是AI infra和芯片企业。

一、大佬们怎么看Sora?

不管是震惊Sora的强大,还是吐槽其生成视频的破绽,都能收获极高的关注度。大佬们也分为几派,从不同角度对Sora进行点评。

1. 吃瓜感慨派:时间不等人,甘拜AI下风

代表之一是马斯克,在社交平台X上的各网友评论区活跃蹦跶,四处留下“人类愿赌服输(gg humans)”“人类借助AI之力将创造出卓越作品”等只言片语。

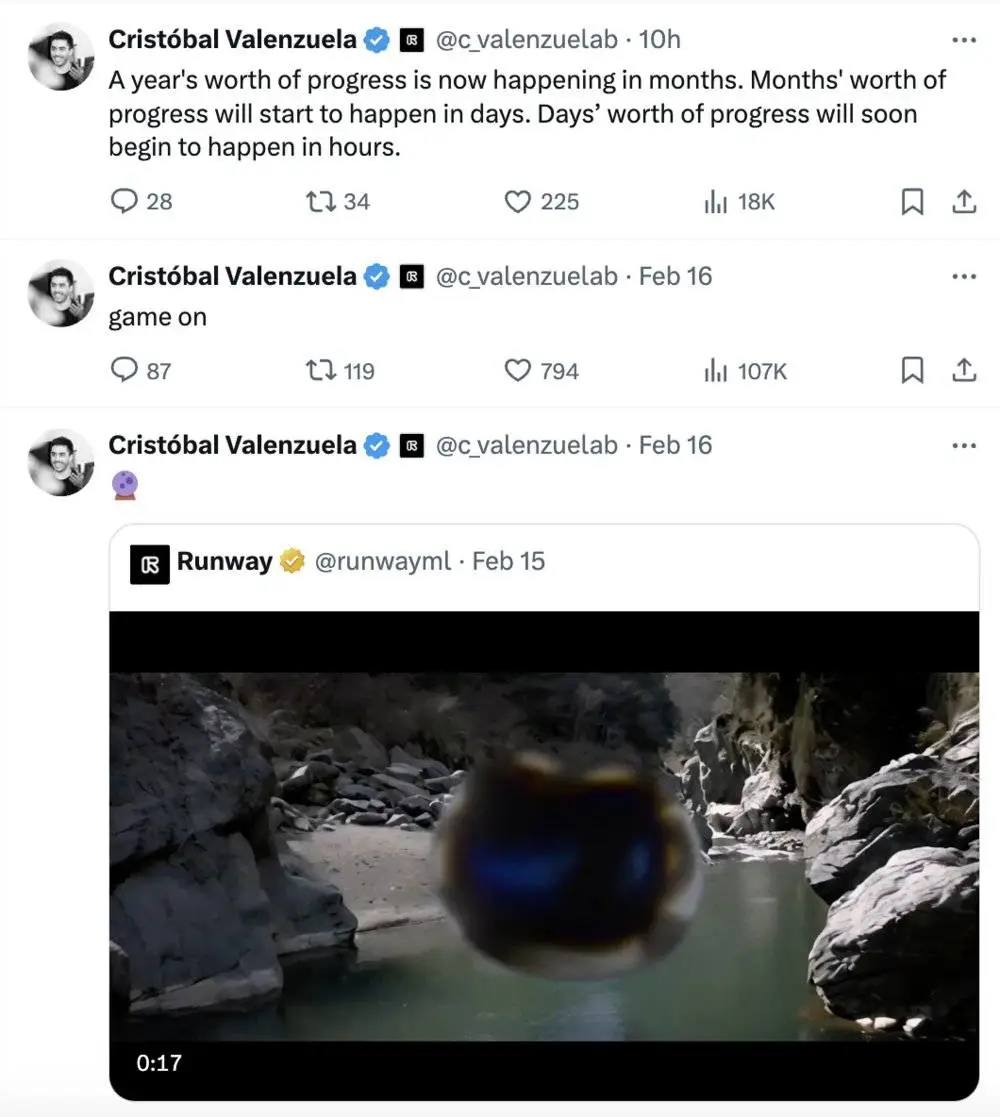

AI文生视频创企Runway联合创始人兼CEO Cristóbal Valenzuela感慨后浪拍前浪,以前需要花费一年的进展,变成了几个月就能实现,又变成了几天、几小时。

出门问问创始人李志飞在朋友圈感叹:“LLM ChatGPT是虚拟思维世界的模拟器,以LLM为基础的视频生成模型Sora是物理世界的模拟器,物理和虚拟世界都被建模和模拟了,到底什么是现实?”

2. 展望预言派:OpenAI还有武器,创企压力倍增

周鸿祎发了一条长微博和一个视频,预言Sora“可能给广告业、电影预告片、短视频行业带来巨大的颠覆,但它不一定那么快击败TikTok,更可能成为TikTok的创作工具”,认为OpenAI“手里的武器并没有全拿出来”“中国跟美国的AI差距可能还在加大”“AGI不是10年20年的问题,可能一两年很快就可以实现”。

美国旧金山早期投资人Zak Kukoff预测:一个不到5人的团队将在5年内用文生视频模型和非工会的劳动力。制作一部票房收入超过5000万美元的电影。

GitHub Copilot主创Alex Graveley则替生成式AI创企们捏了把汗:“如果OpenAI打算继续逐个行业地蚕食AI初创公司,他们应该尽快上市。构建一个只有500人受益的新经济是个糟糕的未来。”

前阿里副总裁、正在AI infra赛道创业的贾扬清,评价简单粗暴:“真的非常牛。”他认为“对标OpenAI的公司有一波被其他大厂fomo(害怕错过)收购的机会”“开源还需要一段时间才能catch up”,算法小厂“要不就算法上媲美OpenAI,要不就垂直领域深耕应用,要不就开源”,并预言“infra的需求继续会猛增”。

3. 上手体验派:比较多个视频生成模型,联动Sora和Gemini 1.5

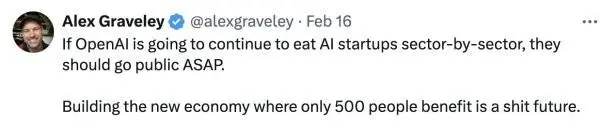

知名连续创业者Gabor Cselle在测试关于美丽东京白雪皑皑的提示词后,得出的结论是Sora在长镜头上表现得更好。

Gabor Cselle还让谷歌Gemini 1.5 Pro观看并分析评论了OpenAI Sora制作的视频。

Sora的原提示词是:“美丽、白雪皑皑的东京市熙熙攘攘。镜头穿过熙熙攘攘的城市街道,跟随几个人享受美丽的雪天,在附近摊位上购物。绚丽的樱花花瓣随雪花在风中飞舞。”

Gemini 1.5 Pro给出的评论是:“这段视频拍摄的是日本一条下雪的街道,樱花盛开。有一些不一致的地方表明视频可能是AI生成的。首先,雪下得很大,但樱花还在盛开,樱花通常开在春天,那时天气温暖,没有雪;其次,雪以一种很均匀的方式落下,这与现实生活中的雪通常不同;第三,尽管下着雪,视频中的人没有穿任何冬天的衣服。总的来说,这段视频在视觉上很吸引人,但前后矛盾之处表明这不是真实场景。”

4. 技术分析派:Sora或有30亿参数,基础论文被扒

含金量最高的当属围绕Sora核心技术的讨论。

PyTorch创始人Soumith Chintala从视频推测Sora是由游戏引擎驱动的,并为游戏引擎生成组件和参数。

英伟达高级研究科学家Jim Fan评价Sora是“视频生成的GPT-3时刻”“数据驱动的物理引擎”,认为它通过一些去噪、梯度下降去学习复杂渲染、“直觉”物理、长镜头推理和语义基础等。

多伦多大学计算机科学AI助理教授Animesh Garg夸赞OpenAI做得好,评价Sora像是“模型质量的飞跃,它不需要快速的工程来实现随时间一致的RTX渲染质量生成”。

纽约大学助理教授谢赛宁高赞Sora是“难以置信的、将重塑视频生成社区”,并发表多篇推文进行分析,推测Sora建立在扩散Transformer模型之上,整个Sora模型可能有30亿个参数。

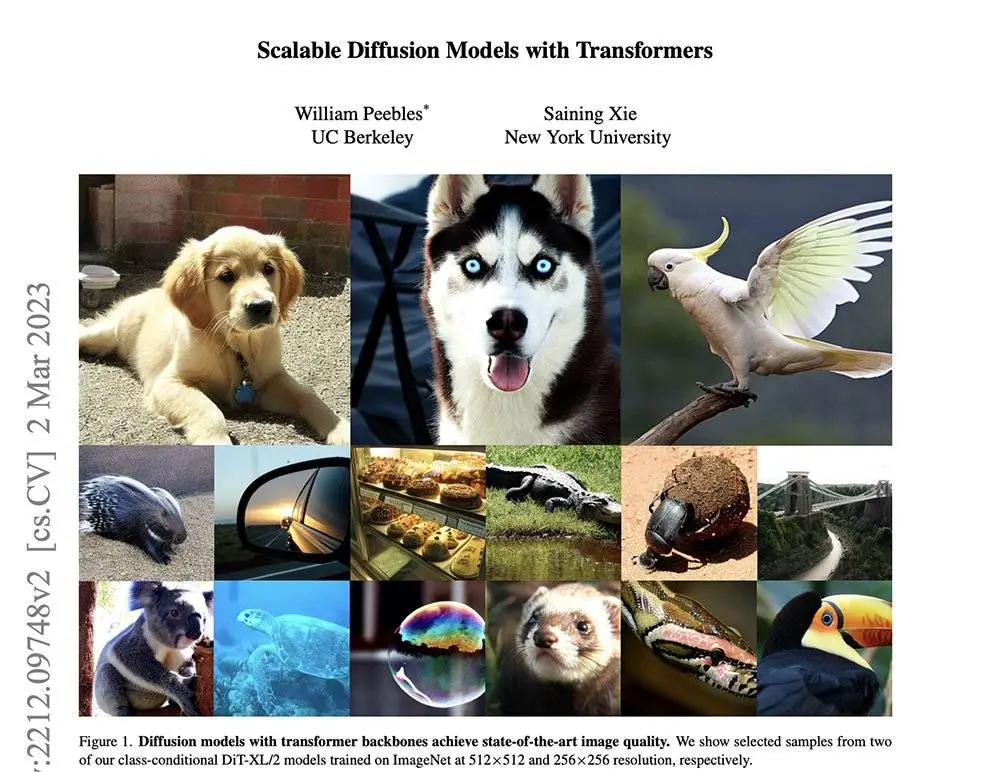

值得一提的是,Meta首席AI科学家杨立昆转发评论称他的前同事谢赛宁和他的前伯克利学生、现任OpenAI工程师的William Peebles前年合著的扩散Transformer论文,显然是Sora的基础。

论文地址:arxiv.org/abs/2212.09748

论文地址:arxiv.org/abs/2212.09748

杨立昆还特意指出,这篇论文曾因“缺乏新颖性”而被计算机视觉学术顶会之一拒收。

下一章将附上大牛们更全面的技术分析。

二、每个视频都能挑出错,Sora为什么还能这么火?

OpenAI在发布Sora的博客文章下方特意强调其展示的所有视频示例均由Sora生成。比起OpenAI的承诺,更能证明Sora清白的是这些视频中出现的各种生成式AI“灵魂错误”。

比如,随着时间推移,有的人物、动物或物品会消失、变形或者生出分身;或者出现一些违背物理常识的闹鬼画面,像穿过篮筐的篮球、悬浮移动的椅子。

这些怪诞的镜头,说明Sora虽然能力惊人,但水平还不够“封神”。这也给它的竞品和担心工作被取代的人类留下了进化的余地。

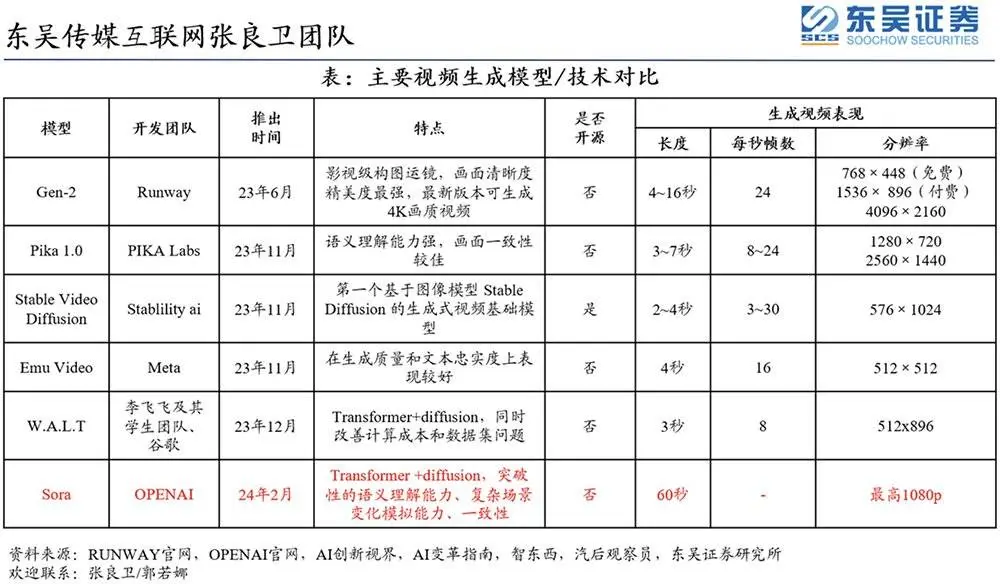

毕竟,AI视频生成已经断断续续火了一年多,而当前最晚出场的Sora,就算是错漏百出,也已经在时长、逼真度等方面甩开同行一条街。

主要视频生成模型/技术对比(来源:东吴证券)

主要视频生成模型/技术对比(来源:东吴证券)

让机器生成视频,难点在于“逼真”。比如一个人在同一个视频里的长焦和短焦镜头里外观不会变化;随着镜头转动,站在山崖上的小狗应该跟山崖保持一致的移动;咬一口面包,面包就会少一块并出现牙印……这些逻辑对人来说似乎显而易见,但AI模型很难领悟到前一帧和后一帧画面之间的各种逻辑和关联。

首先要强调下生成式AI模型跟传统信息检索的区别。传统检索是按图索骥,从数据库固定位置调取信息,准确度高,但不具备举一反三的能力。而生成式AI模型不会去记住数据本身,而是从大量数据中去学习和掌握生成语言、图像或视频的某种方法,产生难以解释的“涌现”能力。

OpenAI在技术报告里总结了一些以前模型常用的视频生成和建模方法,包括循环网络、生成式对抗网络、自回归Transformer和扩散模型。它们只能生成固定尺寸、时长较短的视频。

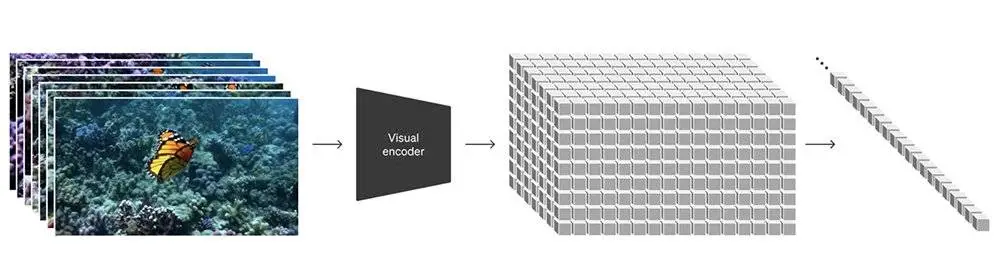

而Sora实现了将Transformer和扩散模型结合的创新,首先将不同类型的视觉数据转换成统一的视觉数据表示(视觉patch),然后将原始视频压缩到一个低维潜在空间,并将视觉表示分解成时空patch(相当于Transformer token),让Sora在这个潜在空间里进行训练并生成视频。

接着做加噪去噪,输入噪声patch后Sora通过预测原始“干净”patch来生成视频。OpenAI发现训练计算量越大,样本质量就会越高,特别是经过大规模训练后,Sora展现出模拟现实世界某些属性的“涌现”能力。

这也是为啥OpenAI把视频生成模型称作“世界模拟器”,并总结说持续扩展视频模型是一条模拟物理和数字世界的希望之路。

令技术大牛们兴奋的焦点就在这个能力上。

扩散Transformer模型论文第一作者谢赛宁发表了多篇推文,分享对Sora技术报告的看法:

先看架构,构建于扩散Transformer(DiT)模型上,DiT=[VAE编码器 ViT DDPM VAE解码器]。

其次是视频压缩网络,看起来只是一个训练原始视频数据的VAE(一个ConvNet),Token化可能在获得良好的时间一致性方面发挥重要作用。

谢赛宁回顾说,在研究DiT项目时,他和Bill没有创造“新颖性”,而是优先考虑了简单和可扩展性。

简单意味着灵活。他认为人们经常忽略掉一件很酷的事,当涉及到处理输入数据时,如果让模型方式更灵活。例如在MAE中,ViT帮助我们只处理可见patches,而忽略掩码patches;类似的,Sora“可通过在适当大小的网格中安排随机初始化的patches来控制生成视频的大小”,而UNet并不直接提供这种灵活性。

他猜测Sora可能还会使用谷歌的Patch n Pack(NaViT),使DiT适应各种分辨率/持续时间/宽高比。

论文地址:arxiv.org/abs/2212.09748

可扩展性是DiT论文的核心主题。就每Flop的时钟时间而言,优化的DiT比UNet运行得快得多。更重要的是,Sora证明了Dil扩展定律不仅适用于图像,也适用于视频——Sora复制了在DiT中观察到的视觉扩展行为。

谢赛宁推测在Sora报告中,第一个视频的质量相当糟糕,怀疑它使用的是基本模型尺寸,并做了个粗略计算:DiT XL/2是B/2模型的5倍GFLOPs,所以最终的16X计算模型可能是DiT-XL模型大小的3倍,这意味着Sora可能有大约30亿个参数——如果是真的,这不是一个不合理的模型大小。这可能表明,训练Sora模型可能不需要像人们预期的那样多的GPU——预计会有非常快的迭代。

在他看来,关键的收获来自“新兴的模拟能力”部分。在Sora之前,我们并不清楚长期的一致性能否独立出现,或者它是否需要复杂的主题驱动生成流水线,甚至是物理模拟器。OpenAl已经证明,虽然不完美,但这些行为可以通过端到端训练来实现。但还有两个要点尚未讨论:

1. 训练数据:完全没有谈论训练来源和构建,这可能只是暗示数据可能是Sora成功的最关键因素。

2.

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!