文章主题:多模态信息交互, 计算机视觉, 深度学习, 图像合成和编辑

今年多模态图像合成与编辑方向大火,前有 DALL-E、GauGAN2,后有统一的多模态预训练模型「女娲」。来自新加坡南洋理工大学的研究者对这一领域内的进展和趋势做了系统的调查梳理。

在现实世界中,信息以多种形式存在,这种多样化的模态对于计算机视觉和深度学习领域中多模态数据的生成和识别具有至关重要的影响。借助于多模态信息交互建模方面的卓越才能,近年来,多模态图像的合成和编辑已逐渐成为一项备受关注的焦点研究领域。

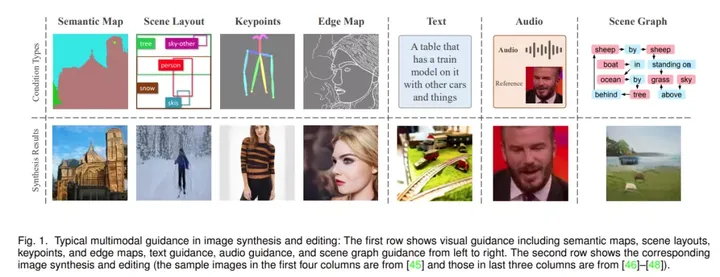

多模态指导作为一种全新的视觉引导方式,与传统的显式线索有所不同,它能够为图像的合成和编辑提供更加直观且灵活的操作手段。然而,这一领域在特征与固有模态之间的对齐、高分辨率图像合成以及公平评估指标等方面仍然存在着诸多挑战,等待我们去克服。

为了深入探讨近期的多模态图像合成与编辑技术发展情况,新加坡南洋理工大学的学者们开展了一项全面性的调查研究。他们依据数据模态与模型架构,制定了相应的分类方法,并在相关领域发表了一篇详尽的综述论文,从而为这一领域的理论研究和实际应用提供了有力的支持。

论文地址:https://arxiv.org/pdf/2112.13592.pdf项目地址:https://github.com/fnzhan/MISE

这篇论文首先深入探讨了图像合成与编辑中的各种指导模式,并通过详尽的框架全面阐述了多模态图像合成与编辑的方法,涵盖了生成对抗网络(GAN)、GAN反转、Transformer、NeRF以及扩散模型等多种技术。接下来,研究对多模态图像合成与编辑领域常用的基准数据集和相应的评价指标进行了全面的梳理,并对各种合成方法进行了细致的比较分析,揭示了它们的优劣之处。最后,针对当前研究的不足及未来可能的发展方向,提出了独到的见解。这项研究将为我国多模态图像合成与编辑领域的未来发展提供重要的理论依据和技术支持。

论文内容概览

图像合成与编辑的核心目标在于打造真实感十足的作品或者优化现有图像的视觉效果。近年来,生成对抗网络(GAN)成为了这一领域的热门技术[1]。为了进一步提升图像生成的可控性,当前的研究重点正逐步转向利用特定的指导条件来生成和编辑图像。在此过程中,分割图以及图像边缘等视觉线索的作用尤为突出,它们对于提升图像合成为止和编辑的效果有着显著的帮助。除此之外,文本、音频以及场景图等多模态的指导信息则为视觉概念的表达提供了更为直观且灵活的方式。然而,如何在不同的模态数据之间有效地检索并整合异构信息,仍然是一个亟待解决的难题,这也成为了图像生成与编辑领域的一大挑战。

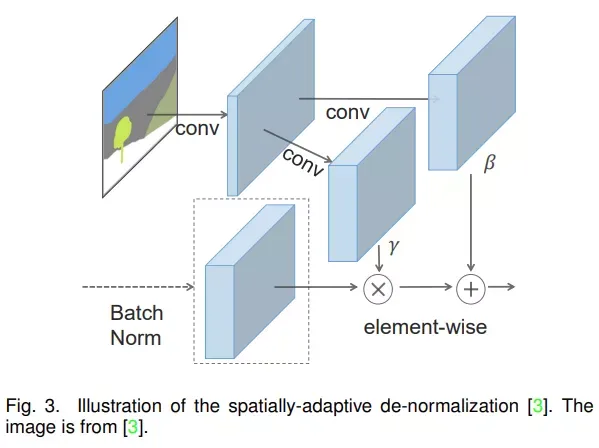

在多模态图像合成领域,E. Mansimov等人在2015年的研究成果[5]标志着一个重要的突破,他们证明了循环变分自动编码器有能力生成带有特定文本条件的新型视觉场景。这一成果的取得,得益于后续多项研究的快速发展,其中包括I. Goodfellow等人于2014年[1]提出的生成对抗网络,P. Isola等人于2017年[2]的研究,T. Park等人于2019年[3]的工作,M. Mirza等人于2014年[6]的研究,M. Arjovsky等人于2017年[7]的努力,以及C.-H. Lin等人于2018年[8]的重要发现。这些研究成果共同推动了多模态图像合成领域的重大进步。

S. Reed 等人 2016 年的论文《Generative adversarial text to image synthesis》[11]扩展了条件 GAN [6] ,以基于文本描述生成自然图像。 L. Chen 等人 2017 年的论文《Deep cross-modal audio-visual generation》[12] 用条件 GAN 实现音乐表演的跨模态视听生成。然而,这两项先驱研究仅能对图像分辨率相对较低(例如 64 × 64)的有限数据集(例如 CUB-200 Birds [13] 和 Sub-URMP [12])进行合成。在过去几年中,改进的多模态编码 [14][15]、新型架构[16][17] 和循环结构[18] 使得该领域取得了显著的进步。另一方面,早期的研究主要集中在多模态图像合成上,很少关注多模态图像编辑任务。

随着大规模 GAN 的发展,领域内又涌现出一系列新型生成网络,如 BigGAN [19] 和 StyleGAN [20]-[22],以从随机噪声输入中合成高质量且具有多样性的图像。

最近有研究表明,GAN 可以在中间特征 [23] 和潜在空间 [24] 中有效地编码丰富的语义信息。GAN 反转 [25] 的方法将给定图像反转回预训练 GAN 模型的潜在空间,产生可由生成器重建给定图像的反转代码,这种方法取代了通过改变潜在代码来合成图像。由于 GAN 反转能够控制在潜在空间中发现的属性方向,因此预训练 GAN 可应用于真实图像编辑,而无需临时监督或昂贵的优化。

许多研究 [26][27] 都试图沿着一个特定方向改变真实图像的反转码来编辑图像的相应属性。在多模态指导方面,StyleClip [28] 利用 CLIP [29] 模型的强大功能为 StyleGAN 图像处理开发了基于文本的接口,而无需繁琐的手动操作。Talk-to-Edit [30] 则提出一种交互式人脸编辑框架,通过操作者与机器之间的对话就能进行细粒度的操作和编辑。

随着允许跨模态输入的 Transformer 模型 [31] 的流行,语言模型 [32]、图像生成预训练 [33] 和音频生成 [34] 等多个领域都取得了显著的进步。Transformer 为多模态图像合成提供了一条可能的新途径。

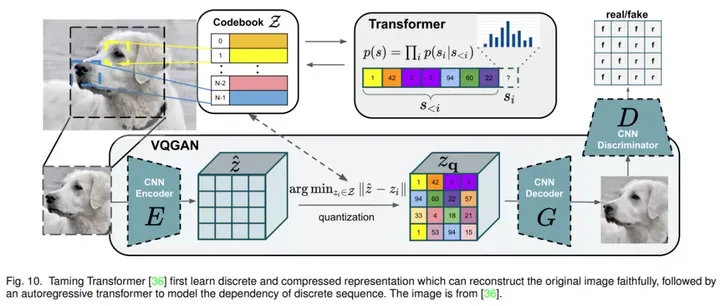

具体而言,DALL-E [35] 表明,在众多图像 – 文本对上训练大规模自回归 transformer 可以通过文本 prompt 产生具有可控结果的高保真生成模型。Taming Transformer [36] 提出用带有鉴别器和感知损失 [37]-[39] 的 VQGAN 来学习离散图像表征,并证明了在高分辨率图像合成中将 CNN 的归纳偏置与 transformer 的表达能力相结合的有效性。

ImageBART [40] 通过学习反转多项式扩散过程来解决自回归 (AR) 图像合成问题,该方法通过引入语境信息来减轻 AR 模型的曝光误差(exposure bias)。前段时间的 NUWA [41] 提出了一种统一的多模态预训练模型,允许使用 3D transformer 编码器 – 解码器框架和 3DNA 机制生成或操作视觉数据(即图像和视频)。

随着生成模型和神经渲染的发展,还有一些研究探索了其他类型的模型,例如神经辐射场 (NeRF) [42] 和扩散模型 [43][44],以实现多模态图像合成和编辑。

论文的主要部分包括第 2 章 – 第 5 章的内容:

第 2 章介绍了图像合成和编辑中流行的指导模态的基础;第 3 章全面概述了具有详细 pipeline 的多模态图像合成和编辑方法;第 4 章介绍了流行的数据集、评估指标和一些典型方法的定量实验结果;第 5 章讨论了多模态图像合成和编辑面临的主要挑战和未来方向。

感兴趣的读者可以阅读论文原文了解更多研究内容。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!