文章主题:AI, 视频制作, 文本转视频, Phenaki

金磊 Pine 发自 凹非寺

量子位 | 公众号 QbitAI家人们,AI做视频这事今天又被推向了舆论的风口浪尖。

起因是有人在网上发布了这么一只小企鹅的视频:

0

0而这个近50秒视频的诞生,靠的仅仅是6句话!

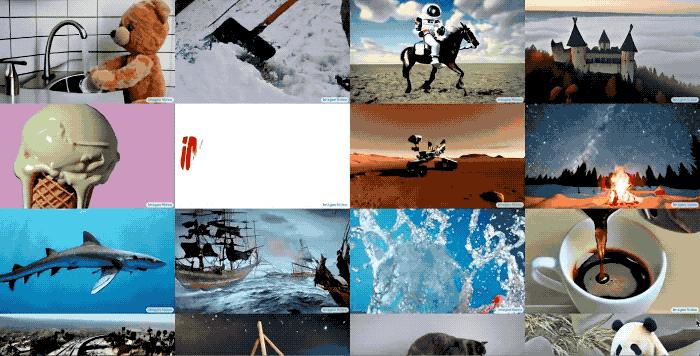

陆陆续续的,网友们还在发布着这个AI的其它杰作:

这次给它投喂的提示词也是极短,仅4行:

如此“所写即所得”、丝滑连贯的视频生成方式,也是令不少网友发出感慨:

未来已至。

甚至还有人开始“拉仇恨”,说AI正在用各种方式摧毁行业……

然后就有很多人发问了:“这又是哪家新搞的AI哇?”

不过眼尖的网友发现它其实是一位“老朋友”了——

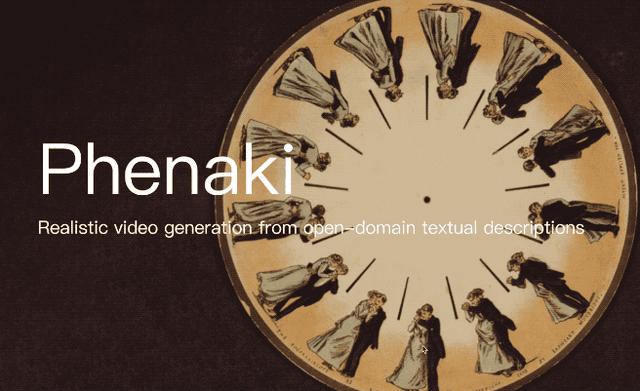

谷歌去年10月份便发布的一个文本转视频(Text-to-Video)模型:Phenaki。

只需一段提示词,分分钟可以生成长达两分钟的视频。

而相比Phenaki刚发布的时候,谷歌又来了一波上新操作。

那么我们现在就来一同看看这些新视频吧~

打字就能生成的视频

与以往AI生成的视频不同,Phenaki最大的特点便是有故事、有长度。

例如,我们再给这么一段场景描述:

在一座未来感十足的城市里,交通纷繁复杂,这时,一艘外星飞船抵达了城市。

在摄像机的逐步拉近下,观众被引导进入了飞船的内部空间;紧接着,摄像机沿着船内的长廊不断前进,最终聚焦于一位宇航员在蓝色房间内的 typing 场景。

镜头逐渐移向宇航员的左侧,身后出现蓝色海洋,鱼儿们在水里徜徉;画面快速放大聚焦到一条鱼的身上。

随后镜头快速从海里浮出,直到看到摩天大楼高耸林立的未来城市;镜头再快速拉近到一撞大楼的办公室。

在这个场景中,一只狮子突然跃上办公桌,开始在桌面上疾驰。摄像机首先捕捉到狮子的面部特写,随后逐渐拉远镜头,此时,狮子已经变形为一位身着西装、脚穿皮鞋的“兽人”。

最后,镜头从办公室拉出,落日余晖下鸟瞰这座城市。想必不少友友们在读这段文字过程中,脑中已经浮现相应的画面了。

接下来,我们一起看看Phenaki生成的效果如何:

0

0是不是和你脑补出来的画面一致呢?

总体来说,这个AI即便面对这种脑洞大开的场景提示词,也是做到了无缝衔接的转场。

也难怪网友们看完这段视频后惊呼“(科技)发展得真快啊”。

而对于篇幅稍短的提示词,Phenaki就更不在话下了。

例如,给Phenaki投喂这样一段文字:

一只逼真的泰迪熊正在潜水;随后它慢慢浮出水面;走上沙滩;这时镜头拉远,泰迪熊行走在海滩边篝火旁。

没看够?那再来一段,这次换个主角:

在火星上,宇航员走过一个水坑,水里倒映着他的侧影;他在水旁起舞;然后宇航员开始遛狗;最后他和小狗一起看火星上看烟花。

在谷歌推出Phenaki之前,他们就已经展示了一项创新功能,即通过输入初始帧和提示词,用户可以轻松地生成一段视频。这一功能展示了谷歌在人工智能领域的技术实力,同时也为广大用户提供了一种便捷的视频制作方式。

例如给定这样一张静态图:

然后再给它Phenaki简单“投喂”一句:白猫用猫爪触摸摄像机。效果就出来了:

还是基于这张图,把提示词改成“一只白猫打哈欠”,效果就成这样了:

当然,任意切换视频整体风格也是可以hold得住的:

网友:视频行业要被AI冲击了吗?

在谷歌发布Phenaki之外,他们还推出了一款名为Imagen Video的产品,其特点是能够生成1280*768分辨率、每秒24帧的高清视频片段。

它基于图像生成SOTA模型Imagen,展示出了三种特别的能力:

能理解并生成不同艺术风格的作品,水彩、像素甚至梵高风格能理解物体的3D结构继承了Imagen准确描绘文字的能力Meta公司很早就推出了Make-A-Video工具,它具有多种功能。不仅可以将文字转换成视频,还可以根据图像生成视频。例如,用户可以上传一张图片,然后Make-A-Video会自动将其转化为一段视频。这种工具非常实用,可以帮助用户快速制作出具有视觉效果的视频内容。

将静态图像转成视频插帧:根据前后两张图片生成一段视频根据原视频生成新视频

……

对于这如“雨后春笋”突然冒出的生成视频模型,不免会让有些人担心:

当然也有人认为现在时机还未到:

0-1总会很快,1-100还是会很漫长。

不过已经有网友在期待靠AI拿奥斯卡奖了:

AI要多久才能成为新的视频编辑器,或者拿下奥斯卡?

原理介绍

再说回Phenaki,有不少网友都比较好奇它是如何通过文字生成这么丝滑的视频的?

简单来说,Phenaki相较于以往的生成视频模型,它更注重时间长度任意性和连贯性。

Phenaki之所以能够在视频生成领域实现任意时间长度的突破,其背后离不开新型编码器-解码器架构C-ViViT的支持。

它是ViViT的一个因果变体,能够将视频压缩为离散嵌入。

在过去的视频压缩过程中,我们常常会面临两个主要问题。其一,编码器未能及时对视频进行压缩,从而使得最终生成的视频时长过短,比如在VQ-GAN的情况下;其二,编码器仅具备固定视频长度的支持功能,因此最终生成的视频长度无法进行随意调整,如VideoVQVAE所示。

C-ViViT是一种独特的方法,它结合了传统视频编码技术和深度学习技术的优势。与传统的视频编码方法不同,C-ViViT能够在时间和空间维度上压缩视频,并在时间上保持自回归的同时,还能自回归生成任意长度的视频。这种方法不仅能够提高视频压缩效率,还能够灵活地适应不同的应用场景。

C-ViViT可以使模型生成任意长度的视频,那最终视频的逻辑性又是怎么保证的呢?

这就得靠Phenaki另外一个比较重要的部分:双向Transformer。

在这其中,为节省时间,采样步骤是固定的,并且在处理文本提示的过程中,能同时预测不同的视频token。

这样一来,结合前面提到的,C-ViViT能够在时间和空间维度上压缩视频,压缩出来的token是具有时间逻辑性的。

也就是说,在这些token上经过掩码训练的Transformer也具备时间逻辑性,最终生成的视频在连贯性自然也就有了保证。

如果还想了解更多关于Phenaki的东西,可以戳这里查看。

Phenaki:

https://phenaki.github.io参考链接:

[1] https://phenaki.video/[2] https://phenaki.research.google/[3] https://twitter.com/AiBreakfast/status/1614647018554822658[4] https://twitter.com/EvanKirstel/status/1614676882758275072—完—

@量子位 · 追踪AI技术和产品新动态

深有感触的朋友,欢迎赞同、关注、分享三连վᴗ ի ❤

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!