通信世界网消息(CWW)随着多模态大模型的不断发展,以“文生图”为代表的人工智能生成内容(AIGC)技术逐步趋于成熟,生成内容的质量与多样性得到了大幅提升,AIGC已为文宣、文档创作、数字人、短视频等领域提供了强大的助力。以Stable Diffusion为代表的扩散模型簇成为“文生图”领域的先进算法之一,该类模型以热力学作为理论基础,采用U-net、Transformer等模型架构,建模图像分布与随机高斯噪声分布关联,进而实现多样化的图像生成。

结合Stable Diffusion模型,中国移动信息技术中心智能AI研发团队提出了一套图像生成与多模态编辑智能体。该智能体能够基于用户输入的文本与条件图像,通过意图识别、槽位提取、任务编排等流程,生成符合用户要求的图像或完成图像内容编辑。目前,该智能体已用于中国移动MOA AI助手、智能交互数字人、妙笔文档等产品中,取得了良好的用户反响。

基于LoRA微调的场景化图像生成方案

为了满足多场景的图像生成需求,研发团队基于Stable Diffusion XL(SDXL)模型,结合LoRA训练策略,构建了一套场景化图像生成方案,如图1所示。该方案主要包括数据准备与预处理、基于LoRA的模型训练以及生成结果后处理三大核心步骤。

图1 基于LoRA微调的场景化图像生成方案

数据准备与预处理

为了解决部分场景数据缺乏的问题,研发团队维护了一个由各公开可商用图片数据集组成的大型数据库,并设计了一套训练样本扩充的自动化方法,减少人工收集与标注工作。其中,数据库中的每个图像包含编号、CLIP图像特征向量与文本标签三个元数据字段。训练样本扩充的自动化方法依托CLIP跨模态对齐模型,生成用户给出的场景示例图像或文字描述的CLIP编码特征。研发团队通过在大型数据库中采用向量余弦相似度检索的方式,检索出相似图像以扩大训练样本。若微调训练数据集还需进一步补充,可采用BLIP“图生文”模型对样例图片生成描述性文本,再通过CLIP文本编码结果在数据库中检索相似图像。

在获取训练图像后,还需按照既定格式生成图片提示语标注文件,并为不同的微调数据集赋予不同的触发词。具体而言,采用BLIP“图生文”模型生成图像描述,再由中国移动九天大模型输出符合SDXL模型训练要求的图像生成提示语。

触发词通常为特殊字符或使用较少的词语,可引导模型在出现提示词的情况下才进行场景化图像生成,减少模型的文本漂移现象,不影响原生SDXL模型的生成能力。

在模型微调之前,需要进一步对图像数据进行预处理。由于原生SDXL模型默认的图像大小为1024×1024像素点,难以满足所有业务场景的需求。针对上述问题,研发团队设计了图像数据的预处理方法,即保持图像原始比例不变,以短边对齐方式进行缩放,最后对长边不足部分补齐或对超出部分进行裁剪。其中,用于补齐部分颜色的RGB值为图片像素均值,避免模型生成结果产生边框。裁剪方式则根据场景而定,当图片主体主要位于中心位置时进行中心裁剪,其他情况进行随机裁剪。

基于LoRA的模型训练

LoRA是一种高效的参数微调方法,在基座大模型上附加轻量的LoRA模型,能够扩展基础大模型能力,实现对新风格、新对象等概念的快速学习。LoRA微调方法是在基座大模型每个Transformer的全连接层中注入可训练的低秩矩阵,而不用对整个大模型进行微调。LoRA模型参数量仅5M~50M,为SDXL基座模型的千分之一左右,因此相比直接对基座模型微调,LoRA模型训练所占内存开销小,训练时长短,在单张显卡上数小时内就可以完成。此外,同一基座大模型可以搭载不同LoRA模型,能在不同应用场景灵活切换,实现“即插即用”的高效场景化图片生成。

图像质量优化模型簇

在图像质量优化模型簇中,主要包含基于传统统计学和基于人工智能的图像质量优化算法。用户可基于上述图像质量优化算法在不同应用场景进行自由选择,也可不进行任何图像优化,以最大程度满足用户对生成图像的期待。同时,本成果也为用户在实际场景提供了默认推荐的图像质量优化模型选择,方便用户使用。通过合理运用图像质量优化模型簇,可显著提升图像生成的质量,在一定程度上优化用户体验。

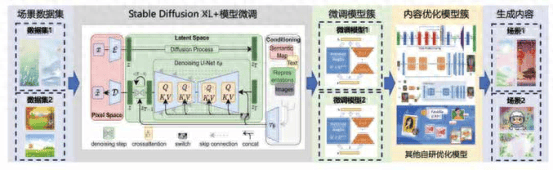

图像内容多模态编辑

在图像生成的基础上,研发团队提出了基于SDXL的图像内容多模态编辑算法,包括基于图像与文本的图像内容编辑和基于文本的自由图像内容编辑,分别适用于精确与自由图像编辑场景。图像内容多模态编辑方法如图2所示。

图2 图像内容多模态编辑方法

基于图像与文本的图像内容编辑

基于图像与文本的图像内容编辑能力需要用户提供一个条件图像作为必要输入,提供一段文本描述作为可选输入,主要用于将提供的条件图像与原始图像进行融合,并尽可能贴近用户提供的文本描述。研发团队基于SDXL和ControlNet模型构建图像内容编辑模型。通过将图像填补技术与ControlNet进行深度融合,克服了ControlNet本身无法在任意指定区域融入条件信息的问题。

图像编辑需要准备图文多模态条件信息,具体包含图像编辑位置与编辑区域大小、条件图像和文本提示语。图像编辑位置与编辑区域大小支持两种方式提供:一是提供编辑位置的中心坐标和区域长宽;二是手动进行编辑区域的框选,根据框选区域获得编辑区域大小。

根据提供的图像编辑位置与编辑区域大小信息,生成图像编辑掩码,掩码值为1的区域为编辑区域,其余区域为0。条件图像为必须提供的条件信息,支持各类图像格式、大小和长宽比,该图像会经过边缘提取与缩放等预处理操作,并填入编辑区域中,获得一张与原始图像大小相同的预处理后的条件图像,将该图像输出Control Net中即可同时实现在指定区域中的条件生成。文本提示语作为补充,可让用户输入对图像编辑的要求,进而对生成图像的风格、细节、结构等进行更精确的控制。文本提示语为非必须项,如用户未提供任何提示语,则模型会自动猜测用户意图,实现条件图像与原始图像的融合编辑。

基于文本的自由图像内容编辑

为了提供更开放自由的图像编辑体验,研发团队还研发了基于文本的自由图像内容编辑算法,用户仅需通过文本描述图像需要修改的部分和内容,便可完成图像内容的编辑,无需提供任何条件图像。

本技术采用Instructpix to pix联合SDXL的实现方案,该方案的关键核心是需要构建基于实际场景的图像编辑数据集对SDXL进行微调训练,使其具备文本提示图像编辑的能力。具体而言,首先采用中国移动九天大模型结合编辑指令生成原始图像的原始描述、编辑描述,再结合Prompt to Prompt方法构建编辑图像,最终形成由五元组(原始图像描述、编辑后图像描述、编辑指令、原始图像、编辑后图像)构成的数据集。

五元组数据集构建完成后可开始模型训练过程,输入编辑指令、原始图像和编辑后图像,要求模型输出的编辑后图像与数据集中的编辑后图像尽可能相同,进而不断优化模型权重。训练完成的模型具备输入编辑指令和原始图像、输出图像编辑的能力。相比基于图像与文本的图像内容编辑,这种图像编辑方法无需用户提供待融合的条件图像,因此更加自由。

图像创作智能体

在图像生成与图像编辑能力的基础上,研发团队还进一步将上述能力封装为图像创作智能体。图像创作智能体结合Bert意图识别模型,可精准解析用户输入的文本指令,随后智能体自动规划任务流程,调用相应模型,高效执行各类图像创作任务,其框架如图3所示。

图3 图像创作智能体框架

意图识别模型采用Bert模型架构,通过构造用户指令语料数据集对Bert模型进行微调,实现智能体的意图识别和槽位解析功能。为全面覆盖用户需求,研发团队构建了一个囊括多样用户行为模式的常用指令数据集,结合业务场景并参考内测日志记录的用户指令,总结了常用句式形成模板。在此基础上,运用中国移动九天大模型分析用户指令的语法与词汇特点(包括口语表达与同义词替换),进一步丰富了指令语料。数据集包括图像生成、图像编辑以及其他三大类意图,其中图像生成意图根据不同业务场景,又细分为文宣、人像、背景、图标和自由生成等类别,并随业务发展而持续扩充。截至目前数据集共包含500余条指令样本,规模约1万token。目前,该成果通过在构建的语料数据集上进行20轮迭代训练,可达到96.4%的意图识别准确率。

在智能体的实际运行过程中,一旦确认了用户意图,智能体即刻启动定制化任务链路,规划相应的任务流程。例如,当用户表示“请帮我生成一张元宵祝福图”时,根据识别到的“图像生成—文宣”意图,智能体会自动触发相应流程,包括加载相应的LoRA权重,通过接口传递解析到的槽位文本“元宵祝福”,完成图像生成和优化,并最终将结果推送给客户端,实现流畅的端到端服务。

中国移动信息技术中心积极拥抱大模型前沿技术,深耕AIGC方向,提出图像生成与图像内容的多模态编辑两项能力。在此基础上,进一步由智能体对两项能力进行统一封装和管理,面向不同的用户需求,调用不同的任务流程并完成任务执行工作。未来,中国移动信息技术中心将持续对该智能体进行升级改造,逐步形成包含图像、视频、音频生成的多模态内容生成智能体,进一步推动AIGC技术在中国移动内外部的落地应用。

*本篇刊载于《通信世界》7月10日*

第13期 总947期返回搜狐,查看更多

责任编辑: