文章主题:

随着生成式AI技术(如Stable Diffusion、Midjourney)和个性化AI图像生成工具(如DreamBooth和LoRA)的不断发展,越来越多的人学会了如何创建静态图像。然而,现在大家已经不再满足于仅生成静态图像。最近,随着模型和算法的优化,AIGC动画趋势已经逐渐显现,不用多久,动画创作也将如Midjourney、Stable Diffusion一样飞入千家万户。我在这篇文章也有提到过相关的趋势:AIGC革命:拐点降临的内容产业,如何赢得时代先机?作为内容创作者要引起足够的重视,因为视频带来的流量机会和商业价值要比传统图文媒介大得多得多。前天,我在视频号发的AIGC视频数据就是最好的证明,这个视频主要用的是AnimeDiff技术实现的,文末有实现效果。 Shadow最近也在做动画的实验,大家可以看看效果:Comfyui的视频工作流经过这些时间探索和研究,Shadow和我一致认为:继图片生成之后,AIGC创作的第二春又要来了!# 什么是ComfyUI?ComfyUI 是一个强大的、模块化的 Stable Diffusion GUI,具有图形 / 节点界面。此 UI 将允许你使用基于图形 / 节点 / 流程图的界面设计和执行高级 Stable Diffusion 管道。换句话说通过拖拽就可以使用Stable Diffusion的完整功能,减轻了不会编程的小伙伴的学习压力。

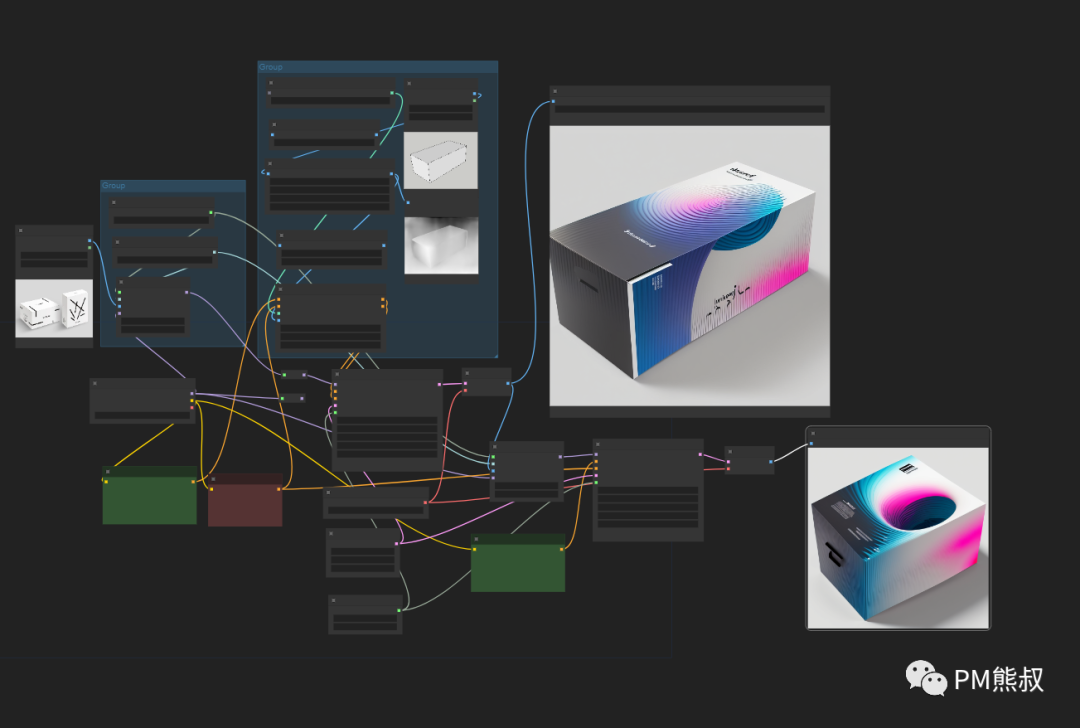

Shadow最近也在做动画的实验,大家可以看看效果:Comfyui的视频工作流经过这些时间探索和研究,Shadow和我一致认为:继图片生成之后,AIGC创作的第二春又要来了!# 什么是ComfyUI?ComfyUI 是一个强大的、模块化的 Stable Diffusion GUI,具有图形 / 节点界面。此 UI 将允许你使用基于图形 / 节点 / 流程图的界面设计和执行高级 Stable Diffusion 管道。换句话说通过拖拽就可以使用Stable Diffusion的完整功能,减轻了不会编程的小伙伴的学习压力。

使用comfyUI搭建的包装设计流程 ( by shadow

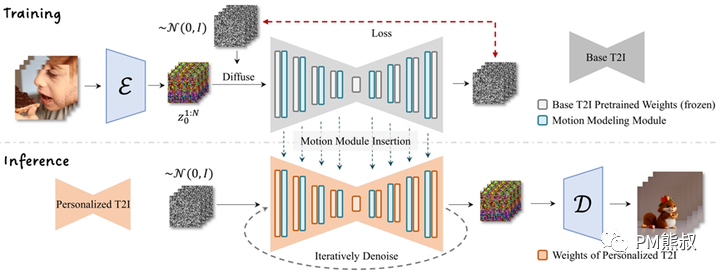

# 什么是AnimateDiff?AnimateDiff是一种生成式AI工具,它能够将文本或静态图像转化为高质量的个性化动画图像,无需复杂的模型微调。AnimateDiff的目标是将Stable Diffusion的能力扩展到动画生成领域。如下面视频所示: 为实现这一目标,AnimateDiff在已通过文本生成的AI图像或模型基础上添加一个新的动画模块,并通过视频剪辑对其进行训练,以生成与原始图像相对应的动画效果。一旦训练完成,用户可以轻松地将这个动画模块应用到各种通过文本生成的AI图像或模型上,从而为它们添加多样化和个性化的动画。 论文地址:https://arxiv.org/abs/2307.04725与现有方法相比,AnimateDiff 由于从大量视频中学习了合理的动作先验知识,生成的动画在连续性上表现更优。它拥有良好的一致性和多样性。最关键的是视频过渡非常流畅,几乎没有闪烁!这一创新性的方法为艺术家、研究者和爱好者提供了一个强大的工具,以更富创意和互动性的方式呈现其生成的图像内容。测试效果:

网友测试最终作品

网友测试测试#动画流程(by shadow# 展望ComfyUI解决了门槛问题,AnimteDiff解决了效果问题,我们相信接下去不久的时间,必然会再掀起一个AIGC热潮。这是每个创作者都不可错过的机会。Shadow和我联合开了个星球《Comfyui动画知识库》,将不断更新相关的资料和内容,我们就是希望通过更简单的AIGC的方式,和大家一起创作出更加丰富有趣的AIGC视频内容。

论文地址:https://arxiv.org/abs/2307.04725与现有方法相比,AnimateDiff 由于从大量视频中学习了合理的动作先验知识,生成的动画在连续性上表现更优。它拥有良好的一致性和多样性。最关键的是视频过渡非常流畅,几乎没有闪烁!这一创新性的方法为艺术家、研究者和爱好者提供了一个强大的工具,以更富创意和互动性的方式呈现其生成的图像内容。测试效果:

网友测试最终作品

网友测试测试#动画流程(by shadow# 展望ComfyUI解决了门槛问题,AnimteDiff解决了效果问题,我们相信接下去不久的时间,必然会再掀起一个AIGC热潮。这是每个创作者都不可错过的机会。Shadow和我联合开了个星球《Comfyui动画知识库》,将不断更新相关的资料和内容,我们就是希望通过更简单的AIGC的方式,和大家一起创作出更加丰富有趣的AIGC视频内容。

早期用户优惠

满50人后开始涨价

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!

刷新

刷新

刷新

刷新

刷新

刷新