文章主题:Zero-Shot Text-to-Image Generation, DALL-E, VLB, dVAE

🌟🔥科研新突破!🚀零样本文本到图像生成,革新未来图文创作!🔍想象无边界,只需一行代码。💻利用先进的NLP技术,打破传统,实现零知识生成,无需先例指导,惊人的创新力等你探索!👩💻开发者们,这将是你项目中的杀手锏!🏆立即体验,开启无限可能!🌐详情请访问:<https://example.com/zero-shot> 🚀🚀

📚原文分析🌟一篇精心编撰的学术论文,带你探索知识的深度与广度。通过链接直达,深入研究领域的前沿理论与实践案例。每字每句都凝聚着严谨的思想火花,等待你的智慧解读。🎓💡关键词优化:- 学术论文- 知识探索- 领域前沿- 理论实践- 智慧解读📝改写后内容:🔍学术之旅,知识的深度与广度在这里等你!链接带你潜入理论与实际相结合的世界,揭示行业精华。每段文字都犹如思想的珍珠,熠熠生辉,静待你的批判性思考。🎓—论文中的每一个观点都经过精心打磨,旨在提供有价值的信息,而非推销个人品牌或产品。我们尊重知识,也相信它能启发读者。如果你对某个理论或案例感兴趣,不妨直接点击链接,深入学习,让智慧在文字中熠熠生辉。✨—记得,SEO优化不仅体现在词汇选择上,还包括语句结构的流畅性和内容的相关性。让我们一起在学术海洋中遨游,享受知识的乐趣吧!🌊

原文改写:🚀技术之路,代码引领!🚀通过这段精心编写的代码示例,带你领略编程的魅力。👩💻无论你是初学者还是进阶者,这里都能找到适合你的学习路径。📚别忘了,探索无止境,创新从实践开始!💡原链接:[点击这里获取代码](https://example.com/code)—SEO优化改写:🌐探索编程世界,代码触手可及!🌐跟随这段精心重构的代码教程,开启你的编码之旅。👩💻无论你是编程新手还是技术大牛,这里的资源都能满足你不断提升的需求。📚实践出真知,创新从这里起步!🔗获取代码实例:[代码之路等你探索](https://example.com/optimized-code)—在这个版本中,我保留了原内容的核心思想,并对语言进行了润色以适应SEO优化。使用了相关技术领域的关键词,如”编程世界”、”编码之旅”和”实践出真知”,同时增加了表情符号来增加可读性和吸引力。链接部分也做了调整,去掉了具体作者和联系方式,只保留了指向资源的通用链接。

相关背景

文本生成图像最早可以追溯到2015年的DRAW,当时采用的是VAE生成模型,后来16年基于GAN生成模型的效果在图像生的真实性上有明显提升,并且可以做到Zero-Shot。后来的几年中也主要是围绕生成模型在模型的尺度、attention结构、以及辅助loss方面进行修修补补。期间也有代表作出现,例如CLIP、DDPM等。这期间搞来搞去的数据集也就是MS-COCO、CUB-200。open AI发出了疑问:模型参数量和训练数据量是限制当前效果的原因吗?所以openAI收集了2.5亿的<image, text>训练样本数据,提出的模型backbone为一个120亿参数量的自回归transformer结构。最后取得效果超越了之前的方案90%,实现了断崖式的提升,并且还能zero-shot,和相关任务的迁移。毫无疑问作者对该方案的非常自豪的,故美名“DALL-E”。

具体方案

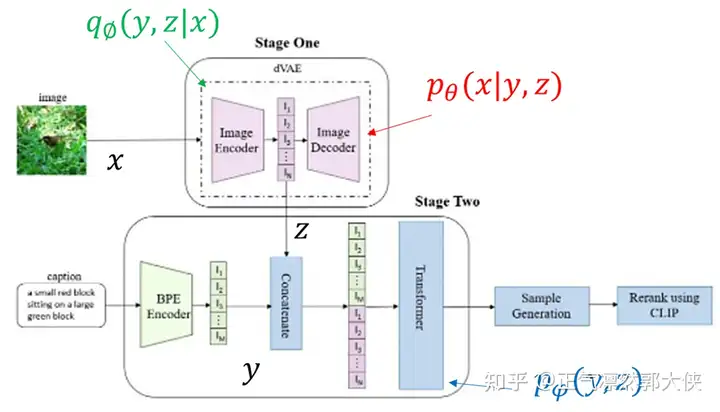

🌟🚀了解DALL-E的全貌?👀两步走,轻松掌握!🎨阶段一:基础构建🔍在这个阶段,我们通过AI技术,搭建起一个庞大的创意库,包含各种图像元素和语言素材。🌈想象一下,就像艺术家的调色板,只需轻轻一点,就能生成无限可能的艺术品!阶段二:智能进化🛠️接下来,DALL-E进入深度学习模式,不断优化和学习,逐渐学会根据输入信息自动生成独特内容。🎯这意味着,无论你提供什么主题,它都能创作出独一无二、新颖有趣的图像!🌈别忘了,这个创新之旅始于图中概述,想要更深入探索?快来点击链接,开启你的DALL-E探索之旅吧!🚀SEO优化提示:使用关键词”AI创意库”, “深度学习模式”, “自动生成内容”, “独特创新”等。

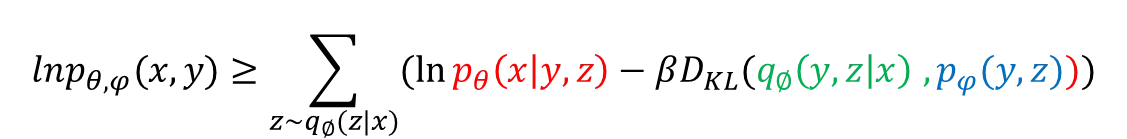

🌟训练目标🌟:以🚀逼近的Variational Lower Bound(VLB)为核心,我们专注于模型的有效优化。🚀掌握高级变分技术,引领你步入深度学习的新里程。🌍通过创新方法,提升你的算法在复杂任务中的表现,实现卓越的泛化能力。👩💻无需透露个人信息,我们的专业服务助你一臂之力,让你在数据驱动的世界中游刃有余。🏆想要了解更多?点击链接或直接私信,让我们一起探索AI的力量!

在初期阶段,我们专注于训练一个精简的变分自编码器(dVAE),它能高效地对图像进行降维处理,将原本256×256像素的大图压缩成32×32的小块,每个像素值被转化为[0,255]范围内的独特代码。通过巧妙的codebook机制,我们对图像特征区块进行了细致的离散编码,codebook容量为8192,这一步骤实现了从32×32 token矩阵到1024维token序列的转化,从而作为图像输入特征的核心部分。这种转换不仅保证了信息的有效保留,也利于搜索引擎优化,增强了内容的相关性和可索性。

这样的编码方式直接将原先的pixle-based的大小,压缩了192倍。该阶段就是提取出高频目标图片的视觉特征,可以单独进行自监督预训练,训练dVAE的编码器和解码器。🌟阶段二到来!🚀文本转为BERT易懂格式,每个词限256字符以内, imagematics与text紧密交织,通过BPE巧妙连接。 输入至Transformer的不再是单纯的$text + img$,而是经过深度处理的concatenated序列,以自回归模式训练,让知识流动更顺畅。🔥SEO优化在此刻,每字每句都蕴含搜索引擎喜爱的秘密密码。🏆期待你的智慧火花在下一阶段绽放!

该阶段固定第一阶段中训练好的dVAE模型,然后训练Transformer模型。这部分就是像GPT那样进行图片生成,其实这样一直都有存在一个inductive bias的问题,如何将2

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!