OpenAI 的 Sora模型将视频生成技术推向了一个新的高度,标志着AI视频生成技术进入了一个新时代。它可以广泛应用于电影、动画、游戏、广告等领域,为内容创作者提供更加便利高效的创作工具。

Colossal-AI 团队首先快速开源了 Open-Sora,这是一个完整的 Sora 复制架构解决方案,同时将训练成本降低了 46%,并将模型训练输入序列长度扩展到 819K 个 patch。

开源地址: https://github.com/hpcaitech/Open-Sora

Sora 算法复制方案

在 Sora 的技术报告中,Sora 使用视频压缩网络将各种尺寸的视频压缩为隐空间中的时空 patch 序列,然后使用扩散 Transformer 进行去噪,最后解码生成视频。

Open-Sora 在下图总结了 Sora 可能使用的训练流水线。

目前,Open-Sora 已经覆盖了:

提供了完整的 Sora 复制架构解决方案,包括从数据处理到训练和推理的整个过程。

支持动态分辨率,训练可直接训练任何分辨率的视频,无需缩放。

支持多种模型结构。由于 Sora 的实际模型结构未知,我们实现了 adaLN-zero、交叉注意力和 in-context conditioning(token concat)等三种常见的多模态模型结构。

支持多种视频压缩方法。用户可以选择使用原始视频、VQVAE(视频原生模型)、SD-VAE(图像原生模型)进行训练。

支持多种并行训练优化。包括结合 Colossal-AI 的 AI 大模型系统优化能力,以及与 Ulysses 和 FastSeq 的混合序列并行。

性能优化

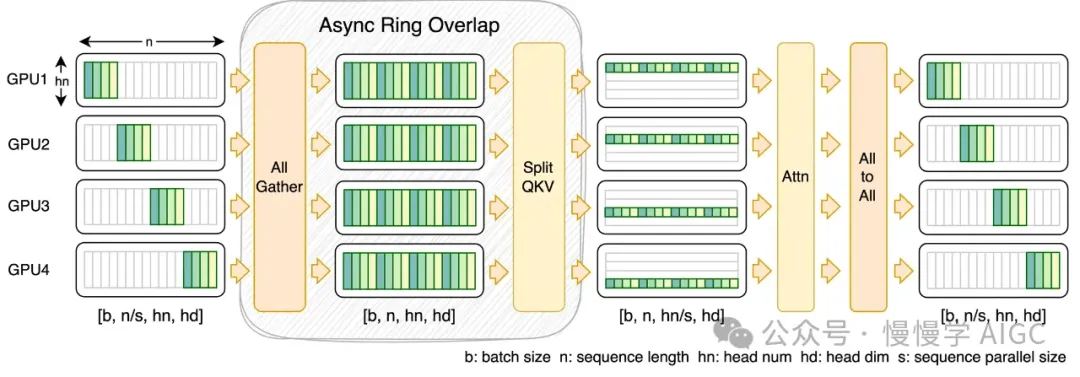

与具有大模型和大激活的 LLM 不同,类似 Sora 的训练任务的特点是模型较小(例如低于10B),但由于视频复杂性,序列长度异常之长。在这种情况下,PyTorch 的数据并行无法运行,而传统的模型并行和无冗余数据并行带来的效益有限。因此,在支持 AMP(FP16/BF16)、FlashAttention、Gradient Checkpointing、ZeRO-DP 等场景优化策略的基础上,Open-Sora 进一步引入了两种不同的序列并行方法实现,可以与 ZeRO 一起使用实现混合并行:

更加通用的 Ulysses,对于小序列或长序列可能表现更佳。

FastSeq 可以重叠 qkv 投影计算和 all-gather 通信,以略微增加一些内存为代价,进一步提高训练效率。

这两种序列并行方案都可以与 Zero2 轻松组合,实现混合并行。

这里展示了在一台配备 8*80GB H800 SXM GPU 的服务器上,使用 DiT-XL/2 模型的性能基准测试结果。

在序列长度为 600K 时,与基准方案相比,Open-Sora 的解决方案提供了超过 40% 的性能改进和成本降低。

Open-Sora 还可以在保证更快训练速度的同时,将训练序列长度扩展到 819K+,长度增加了 30%。

共建号召

Open-Sora 已构建了一个性能优化的类 Sora 视频生成模型低成本开发解决方案,未来将继续更新和优化。

欢迎开源社区和其他力量共同参与构建,复制和超越 Sora,为视频生成领域提供便捷、易用、低成本和可靠的开源解决方案,有效推动 AI 技术在电影、游戏、广告等领域的落地实施。

开源地址: https://github.com/hpcaitech/Open-Sora

参考文献

Liu, Yixin, et al. “Sora: A Review on Background, Technology, Limitations, and Opportunities of Large Vision Models.” arXiv preprint arXiv:2402.17177 (2024)。

Peebles, William, and Saining Xie. “Scalable diffusion models with transformers.”IEEE/CVF国际计算机视觉会议论文集,2023年。

https://github.com/NUS-HPC-AI-Lab/OpenDiT/tree/master

Li, Shenggui,等.”Colossal-ai:用于大规模并行训练的统一深度学习系统。”第52届国际并行处理会议论文集,2023年。

Jacobs, Sam Ade,等.”DeepSpeed Ulysses:用于支持极长序列Transformer模型训练的系统优化。”arXiv预印本arXiv:2309.14509(2023)。