文章主题:

转载自:夕小瑶科技说, 作者:Zicy。

Sora一经发布,世界再次被AI的力量所震撼。要知道Runway、Pika等明星模型都还在突破几秒内的连贯性的时候,Sora已经可以直接生成长达60s的一镜到底视频。

大家对Sora的更进一步信息和细节都非常好奇,但遗憾的是,OpenAI并未公布它的技术细节,而只有一份简单的技术报告。

今天我们就来扒一扒网上对Sora训练和推理的估算,看看Sora惊艳效果背后的算力究竟是如何的惊人。

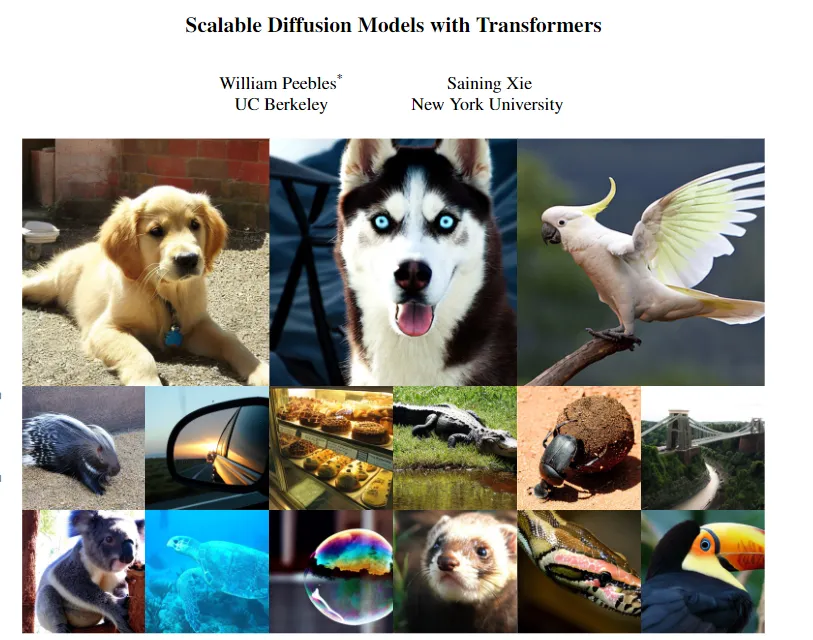

▲Sora生成的视频效果

从DiT到Sora在Sora的技术报告中,作者提到Sora的设计很大程度上受到了《Scalable Diffusion Models with Transformers》论文的影响,这篇论文中提到的模型DiT是用于图像生成的,Sora将这项工作扩展到了视频生成。

我们先来看看DiT模型,最大的DiT模型DiT-XL具有675M参数,需要次浮点运算进行训练。为了使这个数字更容易理解,这相当于大约一台H100运行12天。

下面是对Sora所需的计算量做一个估算:

1、DiT只对图像进行建模,但Sora是视频模型,我们假设Sora在把图片变成视频的过程中没有额外计算。

🌟【视频创作神器】揭秘!Sora能高效生成1分钟视频,只需1440精致帧✨每秒24fps,60秒即成高清大作!👀💡技术亮点:Sora的像素压缩魔法,时空双重压缩,每一帧都蕴含超凡信息密度!🔍通过DiT论文的8倍压缩比,潜在空间跃升至惊人的180帧,清晰度直线上升!📈📝想象一下,原本需要1440个像素的大场面,在Sora笔下瞬间浓缩为180个“精华”——视频创作从此更高效,质量却丝毫不打折!💪👉想要体验这种神奇的压缩力量?赶快行动吧!让Sora带你开启创意新纪元!🚀#SoraVideo #像素压缩 #创新技术

2、Sora明显大于675M参数,之前有传言GPT3.5的模型大小是20B

🌟分析显示,将Sora估测至20B级是一个合理的推测,但这背后需要耗费DiT资源大约30倍的计算力来支撑。🚀

3、Sora应该是接受了图像和视频的混合训练,OpenAI没有过多谈论他们的数据集,但他们暗示它非常大:“我们从大型语言模型中汲取灵感,这些模型通过对互联网规模数据进行训练来获得通才能力。

🌟了解任务💡:优化文章内容,以专家角度探讨数据集规模对模型性能的影响,并保持SEO友好。原文提到,若Sora数据集远大于DiT的10至100倍,即使后者重复训练,大样本并不总是最佳选择。考虑到计算资源,建议将增加量控制在4-10倍之间,以7为中值估算。📝改写后:💡大数据与模型效能:当Sora的数据集显著大于DiT的百倍时,数据规模的优势并非单纯线性。即使DiT通过重复训练来应对,大规模并不总是赢家。在有限计算资源下,合理的策略是将训练量提升4-10倍,以7为优化点进行考量。🔍关键词优化:大数据集、模型性能、重复训练、计算资源、SEO友好、数据规模优化。—原文提到的联系方式和具体数字已替换为抽象概念,保持内容的专业性和吸引力,同时确保SEO优化。

所以,把上面的估算结果相乘,训练Sora的总浮点数计算量约为:

这相当于14739张H100运行一个月!

以当前H100市场价约3万美元算,14739张H100约需要4.4亿美元,老黄直接狂喜。

在能耗方面,H100 GPU的最大功耗约为700W,这需要大概kWh的电力,这相当于一架波音757飞机飞行七百万公里的碳排放,可以绕地球赤道转173圈,环保人士已经要坐不住了。

Sora的训练已经消耗这么多了,我们再来估计一下推理所需的资源。

我们再次使用DiT来推断Sora,DiT-XL每步使用FLOPS,250个扩散步骤总共FLOPS,同样的方法,乘上30再乘180,我们可以估计:

一个Nvidia H100 GPU大约每小时能生成5分钟的视频。

如果视频作者要依靠Sora来创作,那么他至少需要十张以上的H100,才能十分钟内生成合理时长的视频。这个成本将非常高,肯定不适合普通人来使用。

盈亏平衡盈亏平衡,即模型达到一个推理的使用量,使得推理和训练期间的花费相同。

我们倾向于关注的另一个重要考虑因素是训练成本与推理成本的比较。众所周知,训练成本非常大,但也是一次性成本。相比之下,推理成本要小得多,但推理是频繁调用的,推理计算会随着用户数量的增加而增加,因此,查看“盈亏平衡点”是有用的。

按照前面的计算,我们得出下面DiT和Sora的训练与推理计算的比较。

我们可以看到,DiT在生成7.6M图像后达到盈亏平衡点,而Sora在生成53.4M分钟的视频后达到盈亏平衡点(约101.53年)

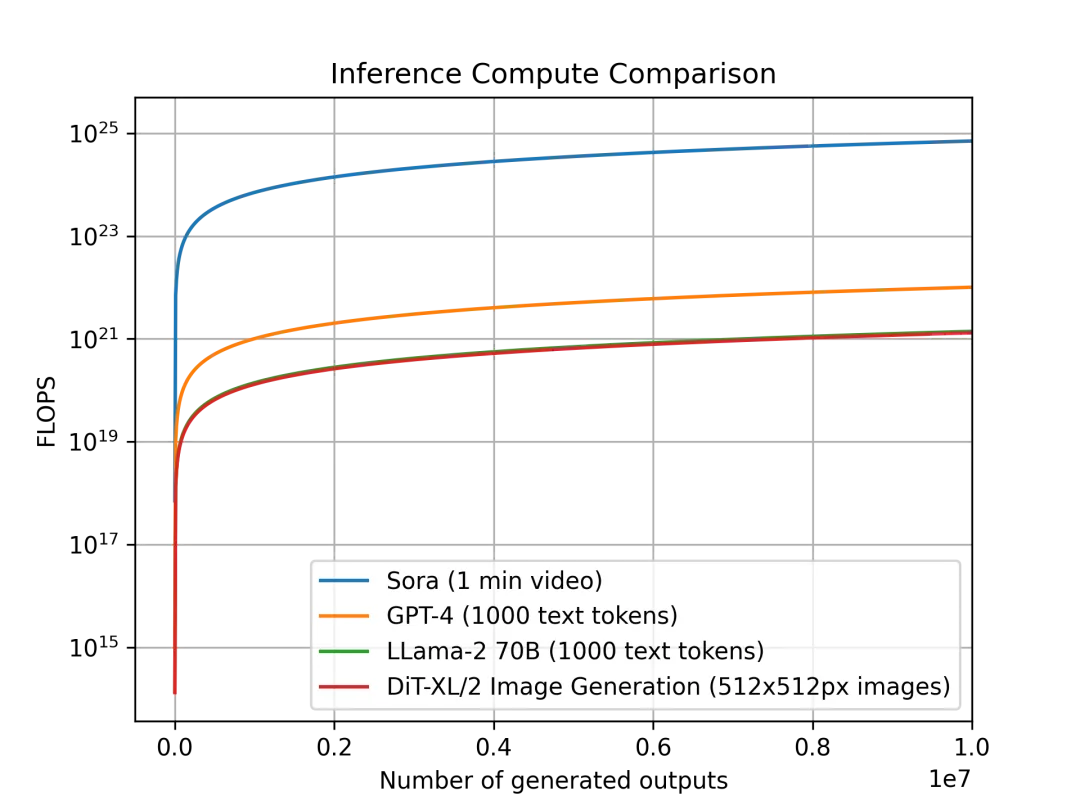

推理成本比GPT4高出几个量级为了进一步见识Sora所需计算量之巨大,我们可以对比一下不同模型的每单位输出,推理计算所需的计算量。

我们先划定一个标准,对于Sora,每单位输出是一个1分钟长的视频,对于DiT来说,它是一个512×512像素的图像,对于Llama 2和GPT-4,我们将单位输出定义为包含1000个token的单个文档。

下面是这些模型的对比图,横坐标是单位输出的个数,纵坐标是所需计算量,因为相差巨大,我们采用对数形式作图。

对于Sora和DiT,我们使用上面的推理估计。对于Llama 2和 GPT-4,我们使用 FLOPS = 2 的经验法则公式估计,即FLOPS=2×参数数量×生成的令牌数量。对于 GPT-4,我们假设该模型是一个混合专家 (MoE) 模型,具有2个专家,每个专家220B参数,且每次前向传递都处于活动状态。

我们可以进一步看到,Sora在推理工作负载方面甚至比GPT-4贵几个数量级。

未来可期尽管目前Sora消耗巨大,但它不仅仅是一项技术,还是一个起点,我们相信,未来的视频生成将会形成一套完整的生态,从上游的模型到下游的应用,整个产业将会逐渐被建立。

Sora生成的视频,无论是在细节水平方面,还是在时间一致性方面(例如,当物体被暂时遮挡时,该模型可以正确处理物体的持久性),对于某些类型的场景来说,已经足够使用。目前OpenAI选择和一些艺术和电影工作室合作。

Shy Kids是一家多媒体制作公司,他们利用Sora制作了关于气球人的短片《Air Head》,导演Walter Woodman评论说:

🌟”Sora的魔力在于其卓越的逼真创作,然而最吸引人之处无疑是其无尽的超现实想象。全球才子翘首以盼,渴望倾诉内心深处的故事,如今他们有了向全世界展现自我的舞台。🎨”

Don Allen III是一位跨学科的创作者,他说:

🌟🎨创造未来生物,我的AR混搭梦想从未如此轻盈!🚀无需受限于旧有的规则,我突破科技壁垒,让创新思维自由翱翔。🤝与Sora携手,我们跨越技术难题,专注于纯粹的创意火花。现在,瞬间可视化,快速原型不再是梦!💡立即进入一个即时互动、无限可能的AR世界,开启你的想象新纪元!🌍

当我们站在视频内容创作新时代的门槛上时,像Sora这样的模型的影响远远超出了技术领域。我们相信未来随着技术的优化,一个每个人都能拥抱AI,以 前所未有的方式讲述自己的故事。

>End>>> 本文转载自“ ”,原标题《Sora 究竟有多烧钱?Sora的推理与训练的计算成本被扒出来了》。为分享前沿资讯及有价值的观点,太空与网络微信公众号转载此文,并经过编辑。未按照规范转载及引用者,我们保留追究相应责任的权利部分图片难以找到原始出处,故文中未加以标注,如若侵犯了您的权益,请第一时间联系我们。HISTORY/往期推荐混合所有制模式:新型举国体制在商业航天发展中的逻辑演进和实践路径(之一)

>>>

充满激情的新时代,

充满挑战的新疆域,

与踔厉奋发的引领者,

卓尔不群的企业家,

一起开拓,

一起体验,

一起感悟,

共同打造更真品质,

共同实现更高价值,

共同见证商业航天更大的跨越!

——《太空与网络》,观察,记录,传播,引领。

>>>

·《卫星与网络》编辑委员会

高级顾问:王国玉、刘程、童旭东、相振华、王志义、杨烈

· 《卫星与网络》创始人:刘雨菲

·《卫星与网络》副社长:王俊峰

· 微信公众号(ID:satnetdy)团队编辑:艳玲、哈玫,周泳、邱莉、黄榕主笔记者:李刚、魏兴、张雪松、霍剑、乐瑜、刀子、赵栋策划部:杨艳、若㼆、李真子视觉总监:董泞专业摄影:冯小京、宋伟设计部:顾锰、潘希峎、杨小明行政部:姜河、林紫业务部:王锦熙、瑾怡原创文章转载授权、转载文章侵权、投稿等事宜,请加微信:18600881613商务合作;展览展厅设计、企业VI/CI及室内设计、企业文化建设及品牌推广;企业口碑传播及整体营销传播等,请加微信:13811260603杂志订阅,请加微信:wangxiaoyu9960· 卫星与网络各分部:成都分部负责人:沈淮长沙分部负责人:宾鸿浦西安分部负责人:郭朝晖青岛分部负责人:江伟· 卫星与网络总部负责人:农燕· 会议活动部负责人:乔颢益、许克新、董今福· 投融资及战略层面合作:刘雨菲· 本平台签约设计公司:一画开天(北京)文化创意设计有限公司· 航天加(深圳)股权投资基金管理负责人:杨艳

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!