文章主题:ChatGPT, NLP, GPT系列

ChatGPT 火了快一个月,期间各种花式对话层出不穷,BOB 我也用 ChatGPT + 画宇宙来进行 AI 绘画创作,效果可以说是非常惊艳了。(参考 是真 AI 就该自己编绘本、谁说 AI 没有创造力?不存在博物馆、AI 绘画怎么画中国元素 IP?)

📚ChatGPT科普大放送🔍!告别那些专业术语云山雾罩的介绍,今天带你揭秘这个AI明星的内在奥秘!从基础的NLP概念出发,一步步带你走进ChatGPT的世界,无需担心复杂度,保证零门槛入门!🚀只需几段轻松话,让你秒懂ChatGPT的工作机制,不再盲目崇拜科技大神!👩💻马上行动,让我们一起探索语言的新边界吧!记得点赞关注哦,未来知识更新不迷路!🌍

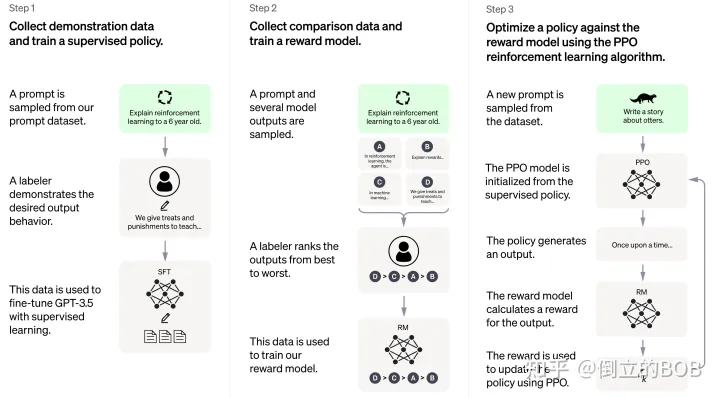

ChatGPT 是在 GPT (Generative Pre-training Transformer)模型的基础上通过改进优化得到的。GPT 是一种大型语言模型,能够生成各种不同的文本类型,而 ChatGPT 则是针对对话场景特别优化过的,它可以根据上下文自动生成跟人类一样的文本对话。下图是 OpenAI 官方对 ChatGPT 的原理介绍,本文也将分这几步为大家讲解 ~

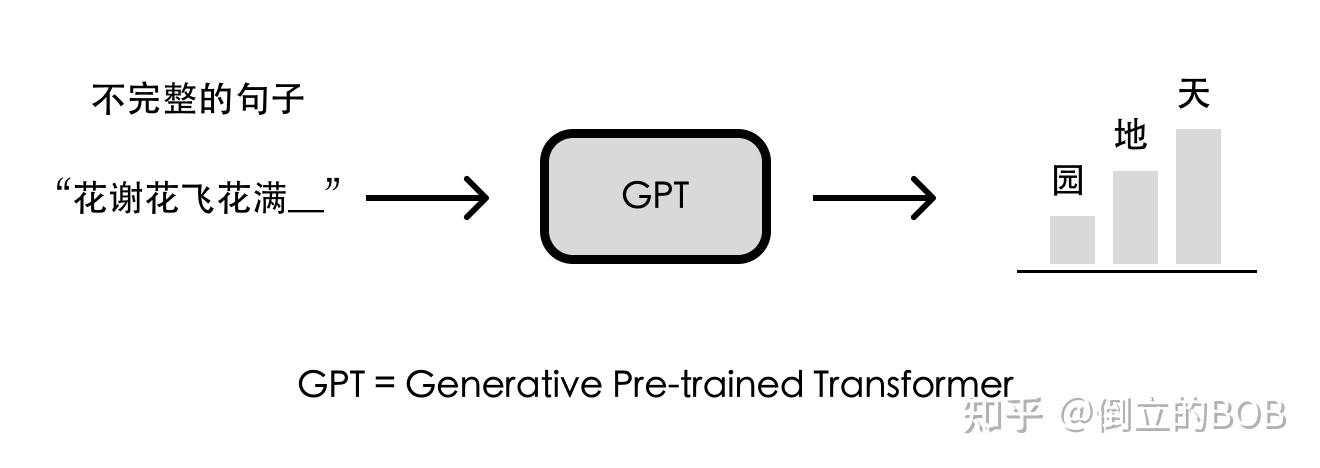

第〇步:文字接龙—— GPT 大模型

🌟🚀 GPT 系列模型背后的创新理念是通过海量无标签数据让 AI 学习文字连贯性,从而实现文本接龙的卓越技能。无需人工标注,只需巧妙遮蔽上下文,AI 自动对比与语料库中的后续内容,就能自我训练。ChatGPT 是 GPT3.5 模型的升级版,作为系列第三代的代表,它在万亿词汇量的通用语言数据集上深度打磨,几乎无所不能——从基础的完形填空、阅读理解,到复杂的语义解析、机器翻译,再到创意十足的文章生成和智能问答。🚀🌈

极简指令:改写以下句子,使其更利于SEO优化,并保持原意。请提供需要改写的句子。

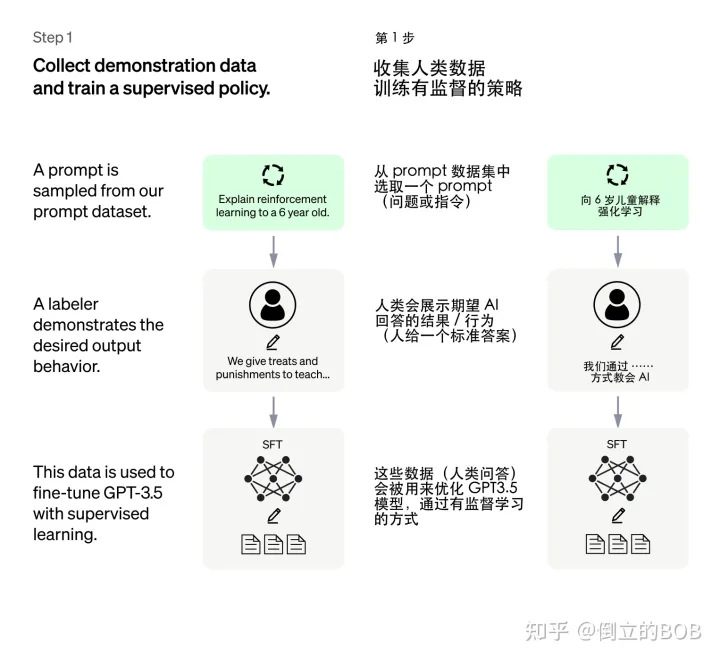

第一步:人类引导接龙方向——有监督训练初始模型

🌟当然,GPT的潜力无限,但它目前在深度理解和生成高质量答案上还有待提升。假设我们以攀登世界高峰为例,提问”珠穆朗玛峰的高度是多少?”,尽管它能流畅地回应”珠穆朗玛峰”,但若期望其提供具体海拔数据或深入解释,还需要额外的引导和信息输入。这就像一个语言学习者初次接触接龙游戏,虽然能模仿,但缺乏实质内容。优化它的智能,使其在知识问答上达到专家水平,是未来需要努力的方向。🌍

研究人员巧妙地将人类智慧融入到AI学习中,他们让人类为特定问题提供人工答案,然后将这些答案与问题一同馈送给GPT系统,这就是所谓的有监督训练过程。这样做就像给AI一个明确的指南,让它学会按照已验证的路径来生成连贯且实用的文字响应。这种策略有助于塑造AI的思维模式,使其朝着我们期待的方向——产出准确且有价值的回应迈进。通过这样的方式,我们得以培育出一个基础版的、功能强大的ChatGPT模型雏形。

🌟重要提示🌟:在这一过程中,无需耗费庞大的人力去穷尽问题与答案的方方面面。这既昂贵又不切实际,毕竟AI自身的创造力不容忽视。实际上,研究人员仅以有限的数万条数据作为训练基础,旨在启发GPT生成满足需求的答案,而并非硬性模仿所有可能。这些数据背后的深层含义是引导AI理解人类偏好,为文本连贯性的路径指明方向。🚀

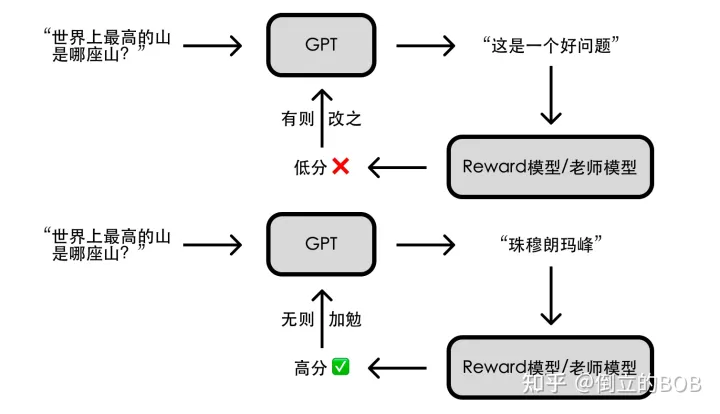

第二步:给 GPT 请个“好老师”—— Reward 模型

如何让这个简易版的 ChatGPT 模型变得更强呢?我们可以参考其他 AI 模型的训练思路,前几年轰动一时的围棋人工智能 AlphaGo,是通过海量的自我对弈优化模型,最终超越人类;能不能让 GPT 通过大量对话练习提升其回答问题的能力呢?可以,但缺少一个 “好老师”。

AlphaGo 自我对弈,最终胜负通过围棋的规则来决定;但 GPT 回答一个问题,谁来告诉 GPT 回答的好坏呢?总不能让人来一一评定吧?人的时间精力有限,但 AI 的精力是无限的,如果有个能辨别 GPT 回答好坏的「老师模型」(即 Reward 模型),以人类的评分标准对 GPT 所给出的答案进行评分,那不就能帮助 GPT 的回答更加符合人类的偏好了么?

于是研究人员让 GPT 对特定问题给出多个答案,由人类来对这些答案的好坏做排序(相比直接给出答案,让人类做排序要简单的多)。基于这些评价数据,研究人员训练了一个符合人类评价标准的 Reward 模型。

第三步:AI 指导 AI ——强化学习优化模型

“你们已经是成熟的 AI 了,该学会自己指导自己了”。要实现 AI 指导 AI,得借助强化学习技术;简单来说就是让 AI 通过不断尝试,有则改之、无则加勉,从而逐步变强。

前两步训练得到的模型在这一步都能派上用场:我们随机问简易版 ChatGPT 一个问题并得到一个回答,让 Reward 模型(老师模型)给这个回答一个评分,AI 基于评分去调整参数以便在下次问答中获得更高分。重复这个过程,完整版的 ChatGPT 就训练好啦!

总结

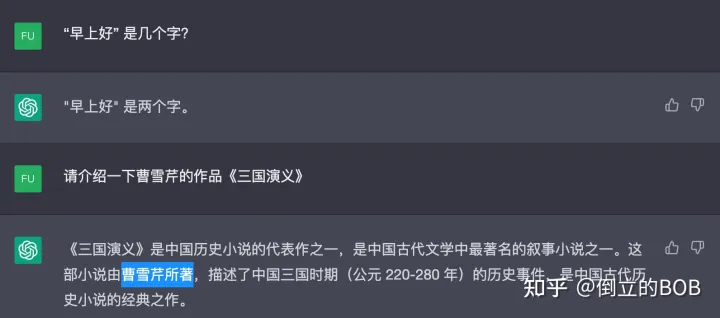

从原理看,ChatGPT 是一个擅长对话的文字接龙高手,它看似能生成自然流畅的回答,但实际上这些回答往往欠缺逻辑性和正确性的考虑,从某种意义上说都是 “一本正经地胡说八道”,因而闹出很多笑话。

不过总的来说,ChatGPT 是一种极具前途的自然语言生成技术,在对话系统、聊天机器人、虚拟助手等领域有着广泛的应用前景(比如本文开头、结尾的一部分是 ChatGPT 写的 ^_^)。希望本文能够帮助读者了解 ChatGPT 的原理,更好地利用它来满足我们的需求。

参考资料:https://openai.com/blog/chatgpt/https://openai.com/blog/instruction-following/chatgpt-possible-4-steps-training【原创】

作者:倒立的 BOB

更多精彩内容请访问 ~

画宇宙 – 人工智能 AI 作画网站

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!