在【AI视频工具】更新1:AI视频真的要爆发了,新出的两款图片 动作生成视频项目、两款声音 图片生成视频项目这篇文章中介绍了国内的两款视频制作工具:阿里的Animate Anyone和字节的Magic Animate。

阿里的Animate Anyone

阿里的Animate Anyone代码未公开,也没有demo产品;字节的Magic Animate代码开源了,我在colab上还搭建了一个应用(https://colab.research.google.com/github/hewis123/MagicAnimate/blob/main/“MagicAnimate_colab00_ipynb”.ipynb),也有人开发成了网页端产品直接使用。

字节的Magic Animate

今天介绍两款与Animate Anyone类似的视频工具,也是国内团队研发的产品:字节的DreamTurner和快手的I2V-Adapter。

字节的DreamTurner

快手的I2V-Adapter

一、字节的DreamTurner介绍

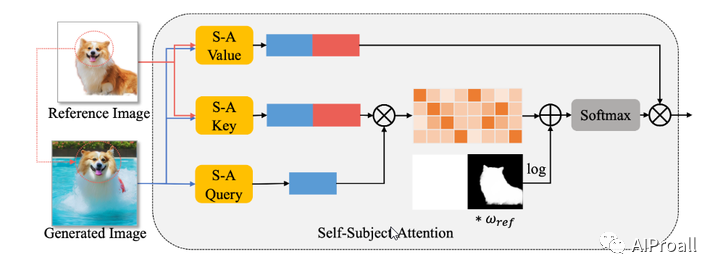

DreamTurner,是一种从粗到细注入定制主题参考信息的新方法。提出了一种用于粗略主体身份保存的主体编码器,其中压缩的一般主体特征在视觉文本交叉注意力之前通过额外的注意力层引入。注意到预训练的文本到图像模型中的自注意力层自然地执行详细的空间上下文关联功能,会将其修改为自主体注意力层以细化目标主题的细节,其中生成的图像从参考图像和自身查询详细特征。值得强调的是,自我主体注意力是一种优雅、有效且无需训练的方法,用于维护自定义概念的细节特征,可以作为推理过程中的即插即用解决方案。此外,仅通过对单个图像进行额外微调,DreamTurner 在由文本或其他条件(如姿势)控制的主题驱动图像生成方面取得了卓越的性能。

项目地址:

https://dreamtuner-diffusion.github.io/

论文地址:

https://arxiv.org/pdf/2312.13691.pdf

二、DreamTurner的技术细节

1、目标:DreamTurner旨在实现主题驱动的图像生成,即从单一参考图像生成高质量图像,同时保持特定主题的身份特征。这适用于需要个性化概念生成的应用,如广告图像制作和故事书创作。

2、挑战:现有方法在平衡主题学习与预训练模型生成能力之间存在权衡问题。微调方法可能会损害预训练模型的生成能力,而使用额外图像编码器的方法可能会因编码压缩而丢失主题的重要细节。

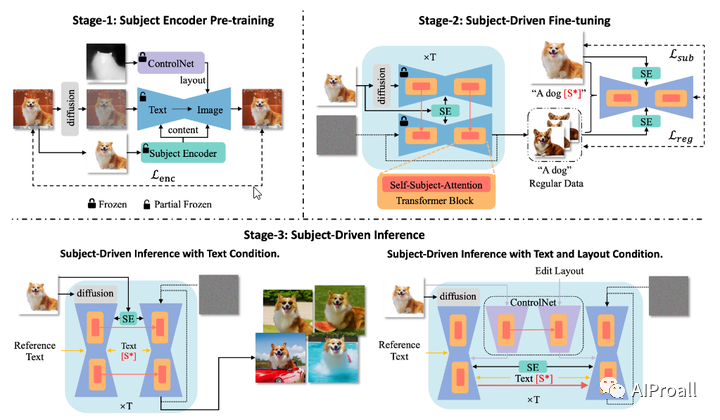

3、方法:DreamTurner提出了一种新方法,通过从粗到细注入参考信息来更有效地实现主题驱动图像生成。它包括三个阶段:主题编码器预训练、主题驱动微调和主题驱动推理。

主题编码器:用于粗略的身份保持,通过注意力层在视觉-文本交叉注意力之前注入压缩的通用主题特征。

自主题注意力:修改预训练文本到图像模型中的自注意力层,使其成为自主题注意力层,以细化目标主题的细节。

主题驱动微调:通过额外的微调步骤增强身份保持。

4、贡献:

提出了一种新颖的主题编码器和自主题注意力方法,用于精细的主题身份保持。

通过主题编码器和自主题注意力,微调过程只需要少量训练步骤。

5、实验:

DreamTurner在主题驱动图像生成方面表现出色,能够由文本或其他条件(如姿势)控制。

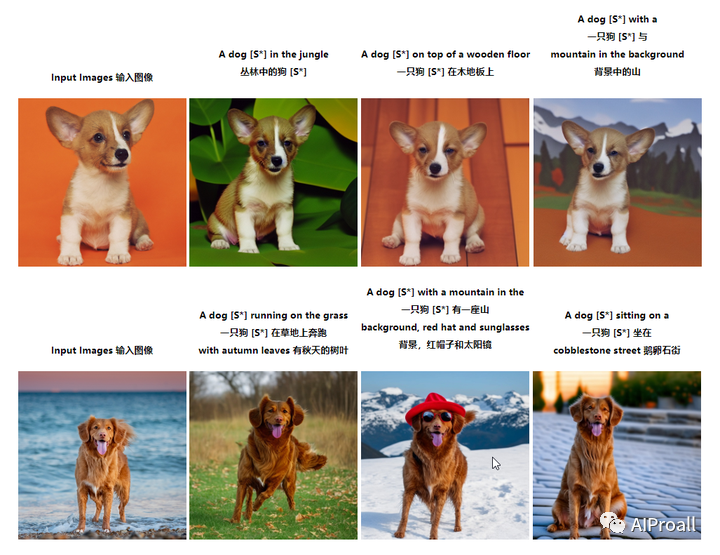

三、DreamTurner产品展示

文本控制动漫人物驱动图像生成的结果

文本控制自然图像驱动图像生成的结果

姿态控制角色驱动图像生成的结果

四、快手的I2V-Adapter介绍

I2V 带来的复杂挑战:将静态图像转换为动态、逼真的视频序列,同时保持原始图像保真度。传统方法通常涉及将整个图像集成到扩散过程中,或使用预训练的编码器进行交叉注意力。然而,这些方法往往需要改变T2I模型的基本权重,从而限制了它们的可重用性。

I2V-Adapter,旨在克服以上限制,保留了T2I模型及其固有运动模块的结构完整性。

I2V-Adapter利用轻量级适配器模块,通过与输入图像并行处理噪声视频帧来工作。该模块充当桥梁,有效地将输入与模型的自注意力机制联系起来,从而保持空间细节,而无需对 T2I 模型进行结构更改。此外,I2V-Adapter只需要传统模型的一小部分参数,并确保与现有的社区驱动的T2I模型和控制工具兼容。这种性能,加上其多功能性和对可训练参数的减少需求,代表了人工智能驱动的视频生成领域的重大进步,特别是在创意应用方面。

项目地址:

https://i2v-adapter.github.io/index.html

论文地址:

https://arxiv.org/pdf/2312.16693.pdf

五、I2V-Adapter的技术细节

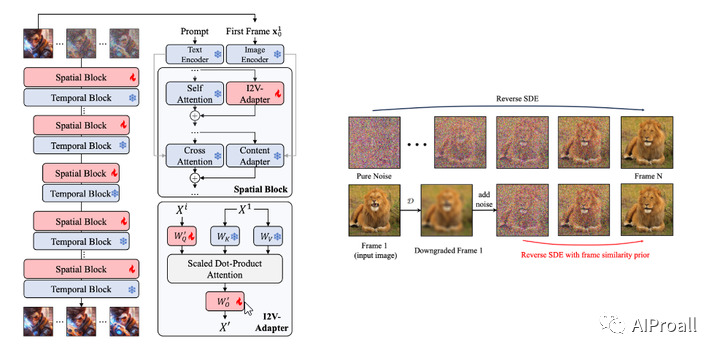

添加图片注释,不超过 140 字(可选)

1、目标:I2V-Adapter旨在将静态图像转换为动态、逼真的视频序列,同时保持原始图像的真实性。它专注于数字内容生成领域,特别是视频扩散模型,特别是文本到视频(T2V)和图像到视频(I2V)。

2、挑战:I2V生成要求模型不仅具有生成能力,而且需要对输入图像有精细的理解,以确保生成的视频内容的一致性和真实性。

3、方法:I2V-Adapter通过并行处理噪声视频帧和输入图像,利用一个轻量级的适配器模块来链接输入到模型的自注意力机制。这个适配器模块作为一个桥梁,有效地将输入链接到模型的自注意力机制,从而在不需要对T2I模型的结构进行修改的情况下保持空间细节。

4、贡献:

提出了I2V-Adapter,一个新颖的轻量级适配器,能够在不训练任何现有的空间或运动模块的情况下实现通用的图像到视频生成。

实验表明,I2V-Adapter能够产生高质量的视频输出,并且与现有的社区驱动的T2I模型和控制工具兼容。

5、实验:

I2V-Adapter在图像到视频生成方面表现出色,能够生成高质量的视频输出,并且与现有的社区驱动的T2I模型和控制工具兼容。

六、DreamTurner、I2V-Adapter和Animate Anyone优势对比及不同

都采用了扩散模型,并在模型设计上进行了创新,以提高生成图像和视频的质量与一致性。

1、DreamTurner

专注于主题驱动的图像生成,强调从粗到细的参考信息注入,适用于需要主题一致性的应用。

优势: DreamTurner能够在只有一张参考图像的情况下生成高质量的图像,并且可以由文本或其他条件(如姿势)控制。它结合了微调和额外图像编码器的优势,通过主题编码器和自主题注意力层,使得微调过程只需要少量的训练步骤。

2、I2V-Adapter

是一个通用的图像到视频转换方法,它通过轻量级的适配器模块来实现,不需要对现有的T2I模型进行结构性修改,适用于需要快速适应和兼容性的场景。

优势: I2V-Adapter能够在不需要训练任何现有的空间或运动模块的情况下实现通用的图像到视频生成。它只需要很少的参数,并且确保了与现有的社区驱动的T2I模型和控制工具(如ControlNet)的兼容性。

3、Animate Anyone

专门针对角色动画,通过ReferenceNet和姿势引导器来保持角色外观的一致性和可控制性,适用于需要角色动画的特定应用场景。

优势: Animate Anyone在角色动画方面表现出色,能够生成清晰且时间稳定的视频结果,同时保持与参考角色外观细节的一致性。它在时尚视频和人类舞蹈合成的基准测试中取得了最先进的结果。

七、其他

由于Animate Anyone只是发布了一篇报告,没有demo产品、没有发布代码,有一些等不及的大神正在推演Animate Anyone的实现过程,在GitHub上公开了代码开发过程,还都在测试阶段,了解一下,可以实时跟踪进展情况,值得期待。做出来了、要是质量很好,Animate Anyone就很尴尬了。

1、AnimateAnyone-unofficial

代码地址:

GitHub – guoqincode/AnimateAnyone-unofficial: Unofficial Implementation of Animate Anyone

项目基于magic-animate和AnimateDiff构建。第一阶段基础测试通过,目前正在进行第二阶段的训练和测试。马上就会发布权重文件。值得期待。

2、MasahideOkada/animate-anyone

代码地址:

https://github.com/MasahideOkada/animate-anyone

项目基于 diffusers 0.24.0 和 AnimateDiff构件。正在开展。

关注我,实时获取 AI 技术的最新咨询。我们致力于CB端AI技术支持 实操教程 行业解决方案 商业应用。