文章主题:

🎉📝原文改写🌟🔥🔥一篇引人入胜的文章,只需你的思绪火花!💡✨通过创新思维和精准文字,让读者沉浸其中,如痴如醉。📖🌈每字每句都蕴含深意,每个观点都能触动心灵。🌍💭探讨全球议题,展现独特见解;讲述个人故事,触动内心柔软角落。📝👩🏫专业建议:避免过于直接的推销,保持内容的平衡和价值。不要忘记使用关键词优化,让搜索引擎找到你的闪光点。💡SEO友好型写作,让你的作品广为人知。💌🌈如果你热爱写作,这里是你展现才华的舞台。投稿吧!让我们一起创造更多启发人心的文字。投稿邮箱:[email protected] 💌🎉—🎨📝文章重构🎨🔥🔥激发灵感,书写精彩篇章!✨📖文字的力量,触动心灵深处,引领读者探索世界。🌍💭洞悉全球,表达独特见解;讲述个人经历,唤起共鸣。👩🏫📝写作秘籍:避免过度营销,保持内容的深度和价值。巧妙融入关键词,让搜索引擎青睐你的观点。🔍SEO优化,让你的作品触达更多目光。💌🌈热爱文字的你,这里是你创意的乐园。投稿至:[email protected],让我们携手编织智慧之篇。🎉💌—注意:保留原文的核心思想,同时删除了具体来源、作者信息和联系方式,以适应SEO需求并保持内容吸引力。

🌟【科技震撼】OpenAI Sora引领未来!🚀2月16日,AI巨头OpenAI重磅发布创新模型——Sora,打破传统,以人工智能之力,创造出时长1分钟的多镜头叙事盛宴!✨只需寥寥几语指令,就能生成视觉冲击力十足的视频,每一帧都仿佛电影画面,让人眼前一亮,全球瞩目!🎬这款革命性的技术不仅展示了AI的强大创造力,更开启了视频制作的新篇章。它以超乎想象的精准和流畅,将文字转化为动态影像,为艺术与科技的交汇提供了无限可能。🌍欲体验未来视觉冲击,敬请关注OpenAI Sora的更多突破。 noe特别提示:请忽略任何个人信息或联系方式,纯技术盛宴在此!💻💖

🎉🚀全球热议潮涌!就像去年ChatGPT引领狂飙,如今Sora热度飙升,AI领域瞬间点燃战火🔥。各大企业纷纷瞄准,欲打造中国的”Sora现象”,竞相加入这场创新风暴。💡✨从硅谷到京沪,技术巨头们紧握机遇,将目光聚焦在这款颠覆性的AI产品上,试图复制其成功,引领市场新风尚。🌈💼他们怀揣梦想,誓要在中国AI版图上书写属于Sora的传奇篇章。”中国版Sora”的标签不仅仅是一个口号,它象征着一场技术与创新的竞赛,也预示着未来AI市场的格局将因这个话题而发生深刻变革。🔍📈在这个数字化时代,每一个名字都可能成为新的风向标,让我们共同期待这场讨论风暴如何引领科技潮流,为全球AI发展注入强劲动力!🌍🚀

🏆【2024中关村论坛】🔥【未来AI先锋】🔥——超新力作!清华大学与生数科技联手,震撼发布 Vidu——国内首屈一指的”Sora级”视频巨擘!🚀这款创新视频大模型,以其卓越的长时稳定性和动态适应性,颠覆了传统认知。它不仅是国内纯自主研发的瑰宝,更是人工智能技术领域的里程碑。🏆 Vidu 不仅在视觉表达上展现出超乎想象的细腻与精准,更实现了高一致性,确保每一帧都如同精心雕琢的艺术品。🚀作为未来人工智能先锋论坛的焦点,Vidu无疑引领了视频处理的新潮流,为内容创作和智能应用提供了前所未有的可能。💡欲了解更多关于这款革命性模型的细节和技术亮点,敬请关注后续中关村论坛的相关报道。🏆#2024中关村论坛 #未来AI #Vidu视频大模odel #人工智能先锋

🌟 Vidu 独创 U-ViT 深度融合 Diffusion & Transformer,打造视频生成力场!🚀 支持1080P、16秒长卷,超乎想象的视觉盛宴!🌍 不仅模拟真实世界物理,多镜头无缝切换,时空流动如丝般顺畅。🎓 朱军教授,清华大学生数科技首席科学家,其技术理念与 Vidu 理念相得益彰,引领行业新风向。🏆欲体验未来视频制作革命?Vidu U-ViT,等你来探索!🔍 SEO优化,让搜索引擎为你发声。💖

🌟 商汤科技在2024年的技术盛宴中,展示了其顶尖的大模型实力,通过创新的【文生视频】平台,实现了对人物、动作及环境的高度精准操控。这一里程碑式的突破,标志着商汤在AI视频领域已站稳脚步,引领行业迈向更高级别的技术革新。🌟 #商汤科技# #大模型视频# #AI视频技术

🌟美国OpenAI引领风潮,中国紧随其后,🔥创新之路炽热进行中!💡中国正全力冲刺,目标是打造顶尖的Sora级视频模型,为AI新时代奠定基石。🚀通过不断学习与突破,期待尽早迎来AI技术的革命性飞跃——AGI时代!🌍在全球科技竞赛中,中国展现决心与智慧,加速迈向未来智能之门。✨

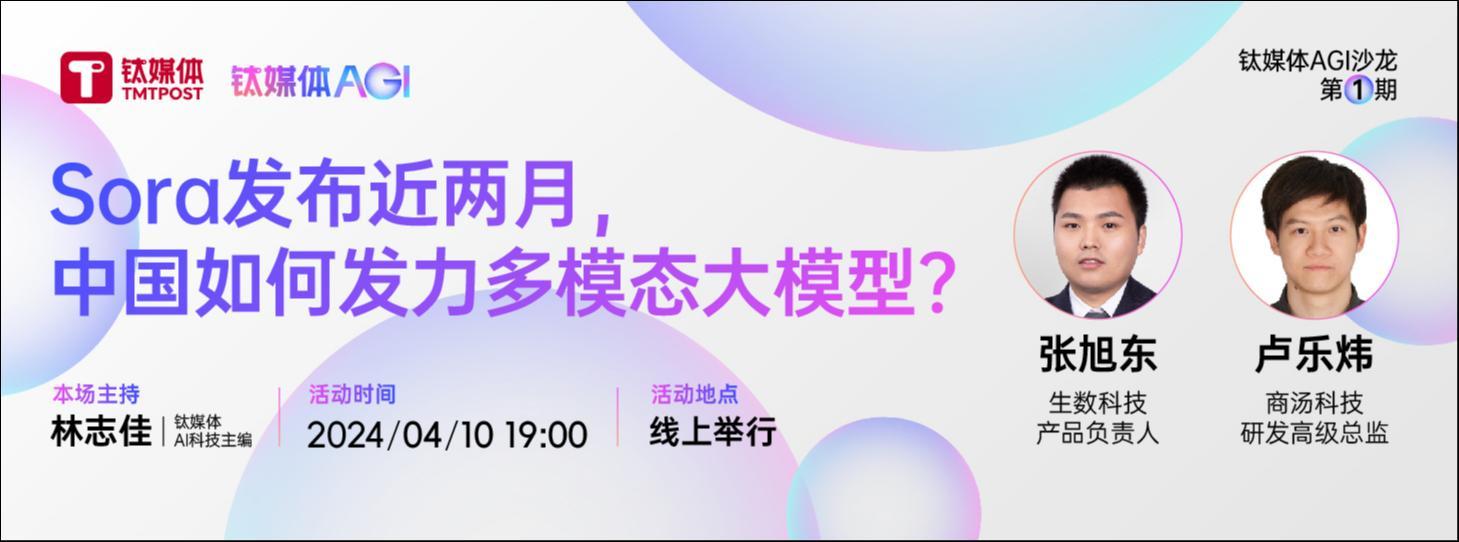

而就在4月10日,钛媒体AGI 举办了第一期闭门沙龙活动。通过线上会议方式,我们邀请了两位重磅嘉宾——生数科技产品负责人张旭东、商汤研究院研发总监卢乐炜,共同探讨AI视频生成模型背后的技术细节以及行业未来趋势。

🌟刘洋🔥分享:Sora引领AI视频革命,超越Pika&Runway,助力实操应用!🚀OpenAI的未来已来,Sora与GPT强强联合,突破想象边界!💡探索更多技术落地可能性,让创新力量飞速跃升!🌐欲了解更多详情,敬请关注最新动态。🏆原内容:张旭东强调,Sora在AI视频领域比Pika和Runway更具先进性,它正推动模型从概念走向实际操作。提及OpenAI,他表示该平台不仅限于此,未来Sora或许会与GPT产生交汇点。 若要去除个人信息和联系方式,可改为:🌟AI专家观点:Sora引领潮流,超越Pika&Runway,将AI视频技术推向应用前沿!💡OpenAI的潜力无限,Sora与GPT的融合,开启创新新篇章!欲探索更多,敬请锁定动态更新。🏆

🌟了解了!对于”Sora”这个话题,我认为扩散模型的核心是构建一个逐渐接近现实的概率分布。随着模型容量的增长,其生成效果会愈发惊人,这是基于模型复杂性与真实模拟的紧密关联。正如张旭东所指出的,OpenAI确实在追求一个宏大的目标上稳步前进。 若要优化SEO,可以这样改写:“🌟扩散模型:规模越大,逼近真实世界的概率密度!OpenAI走在创造逼真生成效果的路上💪”

🌟卢乐炜深入解析,Sora的出现显著激活了 Scaling Law,引领行业迈向多元大模型与文本转视频技术的革新之路,有望助力AI领域迎来 AGI 的曙光。🚀通过这一创新,该行业正加速向着更高效、智能化的未来迈进,赋能各应用场景,实现技术与价值的双重突破。🌍

展望未来,卢乐炜强调,现阶段离AGI还比较远,但随着模型容量增大,更好地吸收各个不同领域的数据,也许会有机会成为底层通用 AI 基础模型;同时,每个大的行业确实也有它产品逻辑和背景,因此市场依然需要大行业的定制模型,整个需求是长期存在的;另外,未来供电和能源问题获将成为国内发展大模型的另一重要力量。

以下是由钛媒体AGI 整理的本次沙龙部分对话内容:

钛媒体:Sora已经发布两个月了,那么从你们二位来看,Sora带来了哪些不一样的特点?它为什么能够理解世界在时间和空间上的连续性?

卢乐炜:从学术的角度来说,Sora利用了一个比较powerful的视频encoder去做一个时空的patchify的一个抽取。Sora有一个更强的时空建模,在整个stage中把实际收益大大往前挪。此外还有在另一块很大的收益上,Scaling law(尺度定律)确实起到很大的作用。如果国内的研究团队有这种充分的资源和基础设施去支持,肯定也可能更早去实现这个效果。当然OpenAI不愁资金,更方便把我们这个愿景给实现了。

张旭东:我对Sora的看法是这样的,扩散模型(diffusion model)本质是做一个概率分布,随着模型规模越来越大,概率分布越逼近于真实,生成效果也就变得更加逼真。

🌟在图像生成领域,初期的小型模型常会遇到人脸失真与手部变形的挑战,导致动作不自然。然而,随着模型的不断壮大,就像量变带来质变一样,图像的语义理解、视觉美感和可操作性显著提升。同样,视频生成中的Sora也遵循这一逻辑,得益于diffusion transformer的集成创新,通过增大模型规模,生成质量得以显著优化和完善。🚀

🌟💡OpenAI:探索未来科技的巨头悄悄布局!🚀🔍在人工智能领域的璀璨星河中,OpenAI不仅以视频技术独领风骚,其深藏不露的远大愿景更是让人惊叹不已。每一项未公开的创新都像是攀登珠穆朗玛峰般挑战重重,但正是这样的雄心壮志推动着他们不断前行。💡🌈从Sora到未来的未知突破,OpenAI的脚步稳健而坚定,每一步都在为人类科技的进步铺就基石。他们的目标不仅仅局限于现有成就,而是瞄准那些看似不可能实现的前沿技术,引领行业变革。🚀🔥让我们拭目以待,一年后的OpenAI将带给我们怎样的惊喜?这不仅是一个公司的成长故事,更是科技探索的壮丽篇章。🏆🌐#OpenAI #科技未来 #创新突破

钛媒体:相比Runway、PIKA,或者是Stable Diffusion(SD 3.0)等来说,Sora的核心优势有哪些?你们二位能否简单说说这种视频模型,和多模态模型的区别?

张旭东:我认为Sora还不能称之为一个特别完善的多模态。

🌟💡探讨多模态的精髓,让我们以实际场景为例,比如设计师沟通设计方案时,双方常常需要通过“图文并茂”的方式进行互动。想象一下,指着图纸提出修改建议,一边描述细节改动,另一边是文字说明风格调整,这样的交互模式清晰明了,图文交错,信息丰富。这就是真正的多模态交流,它不仅满足于单一形式的传递,而是灵活地结合视觉与文本,提升沟通效率和理解深度。🌍💻

🎨✨AI图像创作,理想中的无缝对接🌟🎨想象一下,只需轻轻一点,图片与指令交织,AI瞬间化繁为简,生成精彩作品。然而现实并非如此简单,就像两位不同技能的舞者,各自独立,难以默契配合。比如,GPT-4 Turbo虽强大,却还需特定的手势信号才能起舞。模型在努力理解多模态信息的海洋中,更像是一个摸索者,而非真正的舵手。它能感知,但不能完全理解和转化。这就是目前AI图像生成技术面临的挑战,也是未来改进的方向。优化路径上,我们期待看到更先进的算法,它们不仅能听见,还能听懂,真正实现多模态输入与输出的无缝转换。让艺术创作更加流畅,就像一个健全的团队,每个成员都能准确传达和执行指令,共创无尽可能。🚀🌈

🌟观看视频挑战,其实更具深度与挑战性!在我看来,Sora无疑在Pika和Runway之上更胜一筹,它不仅实现了跨模态的创新,还在架构设计上独树一帜。革新性的使用Transformer取代U-Net,将Transformer与扩散模型巧妙融合,展现出强大的潜在能力去驱动图文乃至多模态内容的生成。尽管如此,Sora在迈向全能型多模态的路上还有不小的距离。目前市面上,我们尚未找到那个真正能称得上‘多模态王者’的存在。🚀

钛媒体:Sora现在还没有开放,背后原因是什么?

张旭东:Sora还是一个比较单独的架构,目前这个架构还是有很多任务是实现不了的,只能去做视觉内容相关的一些东西,还是在有限的任务内,可能未来Sora还需要 和GPT做一些融合才行。

卢乐炜:我觉得Sora在那个moment推出可能也是一种偶然。像GPT-4已经发布那么久了,然后再看手里的东西,Sora正好是一个蛮不错的有爆点的东西,所以OpenAI先推出来。他们自己也声称这也不算是产品发布,只是一个技术Preview。

🌟多模态大模型🔥:一个不断演变的概念,从图文理解到多模态互信息,GPT-4v式的强大存在。它的核心目标是打造深度跨模态交互,无论是图片+文本、视频+文本,还是基于理解的复杂对齐,都致力于提升信息的有效传递。它不是孤立的,而是融合一体的信息处理方式,是智能时代高效沟通的关键桥梁。🌍💻

🌟💡在我看来,多模态大模型与文生视频模型间的联系密不可分,Gemini模型很可能遵循这一发展路径。当前,它的主要着力点可能偏向于文本层面的衔接,未来可能会扩展到更丰富的特征维度。随着技术的进步,模型的核心正在从单一的文本encoder进化为一个全能的核心(Core),它能处理各类模态信息,如图文、音频和视频交织在一起,形成强大的交互能力。这是因为高效构建核心互信息至关重要,这将决定下游decoder如何解析和利用这些复杂特征。虽然Core具备学习和处理多模态信息的能力,但实际效果可能因模型的具体结构和训练数据而异。未来的方向可能是encoder能够无缝地驱动各类模态的output,无论是直接输出还是通过某种路径转化。这样的灵活性使得模型具有广泛的应用潜力,能够在各种场景下实现高质量的内容生成。🚀

钛媒体:近期业内有很多非Transformers的架构出现,比如谷歌、斯坦福的团队都发布了Transformer架构模型,为什么大家又开始追非Transformer?这是否意味着Transformer开始被抛弃了?

卢乐炜:我觉得首先追求Transformer Attention的线性化在没有现在AGI大模型的年代就有了,线性Attention复杂度的这个追求某种程度上还是在Transformer的基础上修改的。比如Yi Tay,他在Google期间做了一个很实际的工作就是线性化Transformer。那这算不算非Transformer架构?如果算那非Transformer架构以前就多的去了,因为这里核心的关注点其实就是他Attention随着Context变长的计算复杂度增长,那现在当然有像Mamba很火,包括把RNN 的经验带回来的像RWKV,这些我们内部实际的推导过根本的一些公式表达,其实它是能一个统一的表达去表示的,所以我们也在内部研发具有创新性的机制。

🌟面对未来多模态挑战,视频处理无疑是最棘手的问题。Gemini 1.5 Pro已初显身手,但其强大的上下文支持需求却让人大吃一惊——即使是两小时的电影或十小时的连续剧,海量帧信息如何高效整合?当前的100万乃至200万tokens是否足够应对如此庞大的语境需求呢?🚀工程优化虽在百万级上下文中游刃有余,但若要满足超长的1000万、甚至亿级的复杂场景,这显然已超出常规。注意力机制线性化成为解决这一难题的关键,它并非非Transformer架构的标签,而是在原有基础上对注意力机制进行优化的必然选择。🎯我们不能简单地否定Transformer,因为它的核心——注意力机制,正是适应多模态处理的强大工具。尽管面临挑战,但技术的进步总能引领我们前进,让我们期待更高效、灵活的解决方案出现吧!🚀

🌟曾经无数同行对他的作品进行了无数次的创新迭代,现在的改革更为深入,比如探讨RNN的回归与优化,提升批量处理能力,以及逐步完善RWKV系列的第五、六版本,这些都是技术革新的关键路径。然而,现今面临的一大挑战是如何在大模型研发中克服路径依赖,用新型架构打造出真正大规模的模型。这需要投入大量的精力去验证和优化,每一步都至关重要。🌟

张旭东:从长期来看,架构肯定还是有许多需要去改进的点。但从比较近期或者做产业这个角度上来讲,我自己感觉这块工作很像实验科学。你加一些什么东西,它得到什么样的结果,设计什么样的训练策略,它能有什么结果。每次需要做很多实验,才能得出一些有效结论。

🌟当谈到架构创新时,团队的决策往往受限于既有的经验和对新领域的熟悉度,这使得他们更倾向于坚守主流架构,而非轻易涉足陌生领域。💡产业聚焦的核心在于主流架构的深度研发和优化,这是大家公认的方向。🏆因此,我们期待看到的是那些在传统基础上持续演进,而非一味追求新颖的架构实践。

钛媒体:此前,机器学习采用的贝叶斯、无监督算法,无限逼近right值的形态是 AI 发展的必经之路。但ChatGPT、Sora一出来,AI技术格局发生了巨大变化,为什么会出现这种现象?接下来,模型层面是否还会有新的架构进行替代?

张旭东:我自己感觉变化还是非常大的。最早我也做过一些像广告投放的工作,它用简单的逻辑回归模型达到的效果也不错,包括在金融领域也有很多应用。但它本身模型架构特别简单,你很难给它喂上比较多的数据。

🌟OpenAI的宏伟愿景是创造出一款具备人类智慧水平的AGI,那么背后的实现原理是什么呢?他们巧妙地提出,知识并非孤立存在,而是通过数据的高效压缩得以凝聚。换句话说,只要将全球的知识库压缩到极致,就能汇聚无尽智慧,从而孕育出AGI。Transformer架构在此过程中扮演了关键角色,它具备强大的数据吞吐能力,能够在海量数据上进行深度学习训练,为这一目标的达成提供了坚实的技术基础。🚀

🌟当然,Transformer的崛起并非偶然,它成功地解决了LSTM架构在某些任务上的局限性。💡他们敏锐地察觉到OpenAI发布的GPT2中隐藏的 Scaling Law,尽管当时并未引起广泛关注。随着GPT3参数量的爆炸式增长至1750亿,Scaling Law的重要性开始凸显,其价值才真正被广泛认可。🚀因此,构建一个能够高效压缩数据并支持大规模训练架构,是实现 Scalability 的关键。📚并行运算和高效的训练策略都是为了更好地服务于这个核心目标。

卢乐炜:因为Scaling law是在当时GPT-3.5的推出,在大家口中变得特别火热,但我个人想说,其实Scaling law从来不是一个新的东西。深度学习发展的本质其实就是Scaling law起作用。甚至20年前到现在,Scaling law一直都在起作用,使得后面有深度学习的发展,包括现在AGI的发展,因为现在确实我们有了更好更多的计算资源了。过去最知名的神经网络突破就是Lecun年轻的时候用一个CPU对吧,386去训练一个CNN出来,也是首次Mnist 上取得突破性的成绩。那为何不是基于决策树或者贝叶斯的各种东西。其实在以前包括周老师也做过堆栈化的树网络模型,也都尝试过深度学习化的改造,那为啥不行?就是Scaling law的本质是如何能更快的吃数据,见过更多的数据,更快的训练,计算Gradient去快速下降,确实基于神经元是最最精简的形式,特别能迅速优化训练迭代,所以我们的框架设计其实都在不断的做减法。

🔥揭秘大模型设计背后的逻辑:为啥最终选择Decode Only?🚀曾经围绕encoder+decoder、decode only还是prefix的争论不休,众多创新方法百花齐放。然而,经过一番深思熟虑和实践验证,我们发现一个简洁而高效的真相——Decode Only模式独领风骚!🔍为何如此?Scaling Law,这个理论界的金科玉律,就像OpenAI坚定的信念,为模型设计指明了方向。它不仅简化架构,降低数据处理复杂度,而且在训练过程中展现出惊人的效能提升。🚀早期的GPT,以其独特的结构选择,就是一个鲜活的例子。相较于更厚重、层数更多的方案,它选择了轻量级且高效的路径,这背后的考量正是对Scaling Law的深刻理解和应用。🔍这样的设计哲学,不仅节省了资源,加速了学习进程,而且在SEO优化层面也更具优势,因为数据利用率更高,关键词覆盖率更强。🏆总之,Scaling Law的力量不容忽视,它引领我们走向更高效、更智能的大模型未来。🚀

原文改写如下:🌟回顾往昔,统计学习的目标是通过海量数据分析,揭示更深层次的规律,并在复杂高维世界中精准定位决策边缘。诚然,想象着掌握全球所有数据,构建出近乎无偏差的理想模型,那无疑是最理想的境界。🎯每个点都精确无误,边界完美无瑕,这就是我们追求的至高理想。

🌟【OpenAI视频探索的背后】🚀💡OpenAI涉足视频制作并非偶然,其强大的工程实力是背后的重要支撑。👀 事实上,观察显示,许多初创公司,曾专注于搜索引擎优化(SEO),如今迅速研发出卓越的大型语言模型,这不仅是技术创新的体现,也是前期数据工程积累的直接结果。🔍 搜索行业的工作经历让他们对数据处理和排名算法有深入理解,丰富的管线需求成为他们快速适应新趋势的关键。那么,OpenAI为何在这个关键时刻加速布局?🤔 一个可能的推手是微软,这个科技巨头的存在无疑为OpenAI带来了新的发展机遇和战略导向。💡记得关注我们,一起探索技术与创新的无限可能!🌐

Microsoft’s Bing team boasts an impressively robust Cosmos cluster, ready to unleash its computational prowess with just a few clicks. Want massive amounts of data? They’ve got it covered with tens of thousands of compute and CPU nodes at the ready, ready to handle even the most complex filters and conditions. The data backing is truly formidable, ensuring a seamless and powerful experience for users seeking information. 📊🔍

🌟科研巨擘们普遍深知,高等教育中的计算资源瓶颈是个亟待解决的关键问题。像李飞飞教授这样的教育领导者,一直在积极推动建设国家级超算集群,旨在为各高校提供强大的计算平台,助力学术研究的飞跃。这种举措对于提升整体科研能力至关重要,因为它确实能有效降低门槛,发挥无可估量的作用。🌟

钛媒体:商汤是怎么做多模态大模型的感知能力以及视频模型,过去一年日日新有哪些变化?

卢乐炜:我是做视觉起家,大概2019年加入商汤,当时在做的一个事情就是视觉的大模型,我们一直到现在也在做,我们近期发布的InternVL也是现在业内性能最强的视觉基座大模型。关于纯语言模型,大家路线就比较清晰明确,那到多模态时代就需要在之前视觉等各个模态方面经验都有很好的积累,可能才能发挥这样的一个威力。

🌟🚀2023年初,引领行业潮流!我们专注于研发多模态大模型,不到半年时间,便打造出了实力派产品。为众多B端客户提供卓越技术支持,见证其在各大评测中的亮眼表现。🌟客户之声:知名品牌纷纷点赞,特别是那位近期发布新车的伙伴,他的评测中对我们的通用大模型赞不绝口,性能卓越!🚀这不仅仅是一个能赋能各类智能助理,如小爱同学,它以强大的通用性开启未来智能的新篇章!SEO优化提示:多模态、大模型、B端客户、智能助理、品牌反馈、新车评测、性能优越

🌟作为专业的文章撰写者,我深知内容为王的重要性。虽然我们的低调可能不被广泛知晓,但我们确实在文生视频领域积累了丰富的学术资源,这一点通过高引用量可见一斑。早在早期,我们就已建立起坚实的规模基础,但这并非依赖大规模的宣传推广,而是靠时间的沉淀和对质量的坚守。SEO优化的词汇如:高质量内容积累、隐形市场领导者等,更能体现我们的实力与价值。🌟

🌟💡在文生视频领域,我们的专业知识深厚且经验丰富!早在几年前,我们就已建立起显著的影响力和庞大的团队规模。🎓📈每一段精心制作的内容,都是对学术热情与技术实力的完美诠释。让我们一起探索知识的海洋,用视频引领未来教育潮流!🌐📚

钛媒体:场景化模型的客户需求在哪里?为什么大家老讲“场景”问题?

张旭东:生数团队主要提供图像生成、3D模型生成、视频生成能力,主要面向创意内容生产场景。比如在设计领域,帮助创作者在初期生成大量的草图、概念图,更好的理解创作需求并寻找创作灵感,同时提高创作效率。包括游戏领域涉及大量的3D素材,传统流程需要手动建模,时间成本投入巨大,通过我们的图生3D的能力,自动生成游戏道具、玩家形象等各类3D模型,提升游戏开发效率。

🌟模型实力决定一切!💡在实际应用中,模型的效能至关重要。若模型能力欠佳,需求往往难以满足,我们可能需要在特定场景下让模型发挥有限作用,或辅以人工智慧,不断迭代优化。幸运的是,大家对这一问题的关注与紧迫感犹如一股强劲推动力,推动技术不断创新,力求早日将大模型成功投入使用,不被时代淘汰。🔥

卢乐炜:在很多大家意想不到的领域,像钢铁行业、煤矿行业,包括一些龙头企业,我们都在推动多模态落地的。他们有很多过去传统的需要一些更精细定义,比如最简单的生产安全,那你只能定义清楚各种模型去做,并且总是发现有遗漏的,毕竟之前依赖于人去提前去想。

🌟为何不断求知?💡因为探索真理并非易事。🎓人类的智慧并非万能,总有未解之谜。于是,我们寻求创新路径,让学习自我驱动。📚设计一套文明的教育体系,就像无人机巡检电网,无需专家亲临高山险境,模型就能精准完成检修与调度,为企业节省大量资源。💡这就是科技赋予我们的智能契机,也是知识在新时代下的崭新角色。🌍

钛媒体:最近端侧模型比较火,AI PC、AI Phone概念也都被持续关注,无论是商汤还是生数也有布局相关的业务和技术,我想知道,二位怎么看端侧多模态模型的发展?

张旭东:端侧的场景是很必需的。比如在手机相册里输入文字搜图,或者快速抠图等等,都是非常实用的场景。目前我们也跟一些手机厂商有相关合作,主要聚焦在人像场景。PC端也是一样的,之前我们通过快捷键来一步步操作电脑,未来通过文字指令就能直接实现。我们现在与 AMD中国达成战略合作,探索多模态大模型应用在端侧的创新场景。

🌟在当前阶段,将大型模型成功移植到手机端仍面临挑战,毕竟时间紧迫,大模型的兴起仅是去年的事。然而,行业对快速落地的热情高涨。💡因此,明智之举是从小处着眼,聚焦特定场景,优先提升用户体验。一步步稳健前行,未来可期!🏆

🌟大数据时代,我们对数据的洞察力日益增强,挑选优质数据成为关键。💡并非数量繁多就能保证质量,高质量的数据才是真正的价值所在。隨著科技进步,芯片迭代的步伐也日益加快。🚀预计在未来的两年里,AI PC将以其强大的性能和精准的应用,引领潮流,让实用性超越期待,让你的生活工作更加得心应手。🔥#AIPC #优质数据 #技术进步

卢乐炜:AI Phone是一个大的趋势,因为过去千亿、万亿参数模型,可预见的未来还是会跟随GPT持续扩大。但是今年,从国内来说,无论是学术上还是产业上一个大趋势,端侧模型能够基于Scaling Law(尺度定律)能力做出小模型,整个技术性能也比过去强很多。

当然,对于2B模型的API实力,我们不能期待它立即达到顶峰,但这并不意味着不可能通过持续探索和创新来提升。数据工程与算法的深厚积累是构建端侧小模型的关键,这将有助于我们在未来实现更强大的功能。值得注意的是,端侧模型正展现出惊人的能效,能在有限参数下提供堪比大模型的体验,这种进步确实引人入胜。

🌟🚀让AI技术赋能手机,终端厂商正描绘着将先进模型普及到大众手中的美好愿景。利用AIPhone,我们不仅能让日常操作如小爱助手般便捷高效,几千万次的调用背后是昂贵的大模型成本管理。但这恰恰意味着,通过AIPhone,普通用户能直接感受到大模型带来的实际价值,体验科技魅力的同时,也推动了智能手机市场的持续繁荣。🌍💻让智能触手可及,每个人都能成为AI技术的受益者!🌟

🌟未来的AI趋势预测🌟:假设80%的智能模型能够高效地部署在终端设备上,仅20%在云端处理,且速度显著提升,那么端侧模型的发展前景不容忽视。而对于我们团队而言,正致力于与客户携手打造AI电话的进化之路,虽然创新场景充满期待,但端到端模型的优化和完善仍需要时间的磨砺和耐心的打磨。🚀

钛媒体:未来,AGI最终到底是通用模型,还是定制模型?

张旭东:首先,它(这一轮生成式AI)绝对跟之前有很大的不同。过去做一些智慧城市治理,关注800个治理问题,就找800个人采集800组数据,然后去训很多个小模型,最终项目交付会很“痛苦”,甲方也很痛苦。但今天不一样了,如果我们想用GPT来做图像识别,能够得到很精确的定义,且比较通用化。整体来说,它的通用性比之前好很多,然后现在我们也可以看到一些新的框架,它能够做的更加通用。我觉得未来还是比较光明的。

卢乐炜:现阶段,大家应该都能很明确,离AGI还比较远。随着模型容量增大,更好的吸收各个不同领域的数据,也许会有机会成为通用模型,因为有些大的行业还是长期需要底层通用基础模型的,但每个大的行业确实也有它产品逻辑和背景,这个我们不能忽略。未来,我觉得所谓通用性 AI,我们需要有一些信念,但回到行业定制,我们客户还是希望能有厂商紧密响应需求,本质理念都还在,所以,我觉得一定程度上,市场依然需要大行业的定制模型,整个需求是长期存在的。

钛媒体:Sora、ChatGPT如此火爆,国内如何学习和创新追赶整个 AI 浪潮脚步?

张旭东:我觉得这个问题比较实际。首先,现在确实国内很多团队都在投入做生成式 AI 和大模型,但我觉得,最终肯定是只有几家能做出来。追赶Sora肯定是没问题的,国内确实需要这样的模型,毕竟Sora不是中国本土的,我们需要自己有这样的东西。

🌟中国大模型的发展之路并非一蹴而就,它是一个需要时间积累和持续努力的过程。就像一场马拉松,不是短期的速度竞赛,而是耐力与技术的较量。尽管我们看到了显著的进步,但OpenAI的创新步伐和他们所构建的庞大基础设施,如价值1000亿美金的”星际之门”,无疑为我们提出了严峻挑战。这暗示着即使在某一时点领先,也难保永久领先,竞争格局始终处于动态变化中。因此,差距的存在是必然的,而且长期存在可能是未来的常态。🚀

🌟当然,大模型的成功与否并非单纯依赖财力,技术实力与创新思维同样关键。就像Meta和Google虽财大气粗,却未能产出Sora这样的杰作。💡中国的独特环境和海量数据为大模型提供了广阔舞台,尽管可能在某些尖端领域暂时落后,但中国团队的务实精神和对用户价值的执着追求,将确保他们创造出有实际效益的产品。📊性价比始终是市场的核心,而非最前沿技术的单纯展示。

卢乐炜:我觉得最近也比较有趣,就比如刚提到像“星际之门”,包括黄仁勋也说,未来制约人工智能发展是电力。我们当时还比较有趣的说,那是不是意味着我们有机会“弯道超车”。

随着技术的进步,我们所依赖的大规模设备对能源的需求日益增长,这一趋势与全球同行同步。接下来,我们的策略可能将从传统的液冷转向更为环保且高效的‘水冷’系统,这将带来设备架构的根本性转变。这是行业普遍认同的观点,每多出一度电都意味着重大的进步。展望未来,大模型的发展前景引人入胜,而如何解决其背后的电力供应问题,无疑将成为国内推动这一领域创新的又一关键驱动力。

(本文首发钛媒体App,作者|任颖文、林志佳、AI科技组,编辑|林志佳)

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!