ELLA(Efficient Large Language Model Adapter,高效大型语言模型适配器)由腾讯研究人员开发。该技术旨在提高文本到图像生成模型在处理复杂文本提示时的语义对齐能力。通过整合大型语言模型(LLM),ELLA极大增强了模型的文本对齐性能,而这一切无需对U-Net或LLM进行额外的训练。

ELLA的功能特性:

语义对齐增强:通过与大型语言模型(LLM)的结合,ELLA提升了扩散模型对文本提示中的多样对象、细节属性以及复杂关系的理解,生成与文本提示更加匹配的图像。时序感知语义提取:ELLA的Timestep-Aware Semantic Connector(TSC)模块能够根据扩散过程中的不同时间步骤动态提取语义信息,让模型在图像生成的不同阶段重点关注相应的文本内容。无需重新训练:ELLA的独特设计使其能够直接应用于现有的预训练LLM和U-Net模型,免除了额外训练的需求,节约了大量计算资源和时间。高度兼容性:ELLA能够无缝集成进现有的社区模型(例如Stable Diffusion)和下游工具(例如ControlNet),增强它们处理复杂文本提示时的性能。灵活的token长度:在 ELLA 的训练过程中,使用了长合成字幕,最大 token 数量设置为 128。在使用短字幕测试 ELLA 时,除了前面提到的字幕上采样技术外,还可以使用“flexible_token_length”技巧。这涉及将标记生成器设置max_length为None,从而消除任何文本标记填充或截断。我们观察到,这个技巧可以帮助提高与短标题相对应的生成图像的质量。Github地址:

https://github.com/TencentQQGYLab/ELLA

ELLA的模型概述

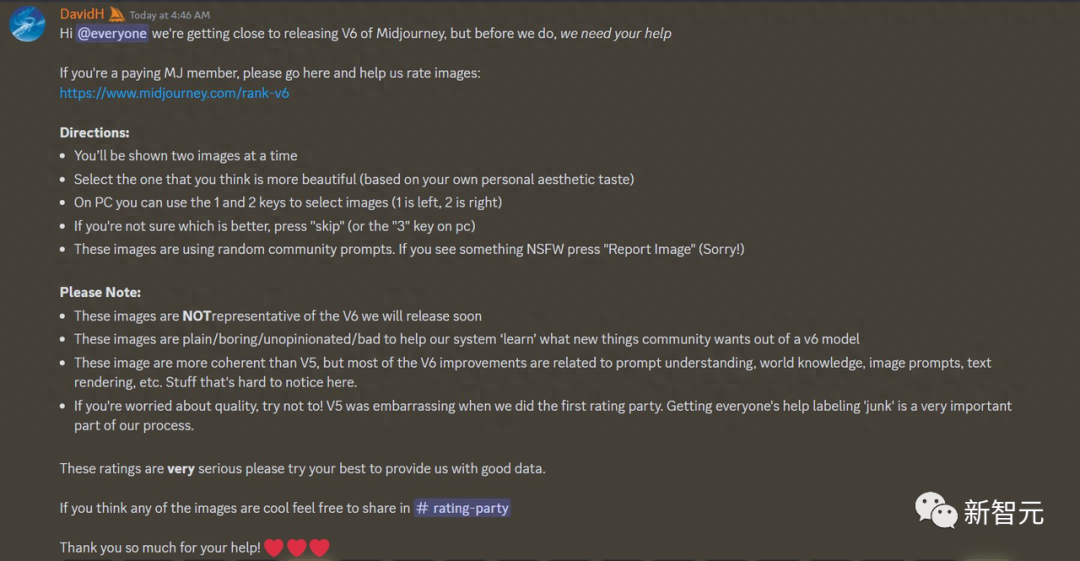

扩散模型在文本到图像生成领域表现出了卓越的性能。然而,这些模型中的大多数仍然使用 CLIP 作为文本编码器,这限制了它们理解密集提示的能力,这些提示包含多个对象、详细属性、复杂关系、长文本对齐等。在本文中,我们引入了E高效的大型语言模型适配器,称为 ELLA,它为文本到图像的扩散模型配备了强大的大型语言模型 (LLM),以增强文本对齐 没有接受过 U-Net 或 LLM 的培训。为了无缝桥接两个预训练模型,我们研究了一系列语义对齐连接器设计,并提出了一个新颖的模块,即时间步感知语义连接器(TSC),它可以从 LLM 中动态提取与时间步相关的条件。我们的方法适应去噪过程不同阶段的语义特征,协助扩散模型解释采样时间步长的冗长而复杂的提示。此外,ELLA 可以轻松地与社区模型和工具结合,以提高其提示跟踪能力。为了评估密集提示跟踪中的文本到图像模型,我们引入了密集提示图基准(DPG-Bench),这是一个由 1K 密集提示组成的具有挑战性的基准。大量实验证明,与最先进的方法相比,ELLA 在密集提示跟踪方面具有优越性,特别是在涉及不同属性和关系的多个对象组合中。

我们提出了一种新颖的轻量级方法 ELLA,为现有的基于 CLIP 的扩散模型配备强大的 LLM。无需经过 U-Net 和 LLM 的训练,ELLA 就可以提高提示跟随能力,并实现文本到图像模型的长密集文本理解。

我们设计了一个时间感知语义连接器,以在各个去噪阶段从预训练的 LLM 中提取与时间步相关的条件。我们提出的 TSC 在采样时间步长上动态调整语义特征,从而有效地在不同的语义级别上调节冻结的 U-Net。

ELLA与主流AI模型对比:

如何下载资源?

1:下载压缩包

首先,您需要从以下链接下载一键启动包:

下载地址:https://www.aigchouse.com/1112.html2:启动程序

下载完成后,解压压缩包,点击”一键启动”

3:浏览器操作

在浏览器中访问 http://127.0.0.1:8082/,即可通过界面使用工具。

责任编辑: