文章主题:DALL-E, dVAE, Transformer, CLIP

Paper: https://arxiv.org/pdf/2102.12092.pdf

Code: https://github.com/lucidrains/DALLE-pytorch

DALL·E 是 OpenAI 的多模态预训练模型,通过120亿参数的模型,在2.5亿图像文本对上训练完成

🎨✨DALL-E背后的创新🔥🔍——探索两步智能艺术之旅🎨🚀第一站:揭开神秘面纱——dVAE🌟走进DALL-E的世界,你会发现它是个巧思满满的艺术家,用离散变分自编码器( çevrimiçi değişkenlik otomatik kodlama, dVAE)这把神奇画笔,将图像转化为一个个独特的tokens。每一片像素都承载着细腻的创意,等待着跃动于屏幕之上。🚀第二站:融合视听盛宴——Transformer主导🌟然而,艺术之旅并未止步于此。DALL-E的第二个阶段,就像一位音乐家,巧妙地将视觉与文本元素融合,以Transformer架构为核心,创作出跨越感官的艺术品。这一步,让想象力无边界,创意无限可能。🔍SEO优化提示:使用相关关键词如”离散变分自编码器”, “Transformer生成模型”, “图像和文本特征融合”等,同时保持内容的连贯性和吸引力。记得,每一次阅读都是对创新的探索,让我们一起在DALL-E的艺术世界里畅游吧!🎉

🌟💡文章灵感库大揭秘!🚀探索创新路径时,BEiT的MIM预训练策略和dVAE模型可不是秘密武器!它们巧妙地通过\dVAE的智慧,为MIM任务提供了强大的基础。而CLIP的重排思路,就像一把开启知识大门的钥匙,直观且高效。💡🔍这样的设计思路不仅实用,而且启发性强,是提升创作灵感的好帮手。🌟别忘了,借鉴这些思路时,记得融入自己的独特视角,让作品更具创新性和深度哦!📚✨

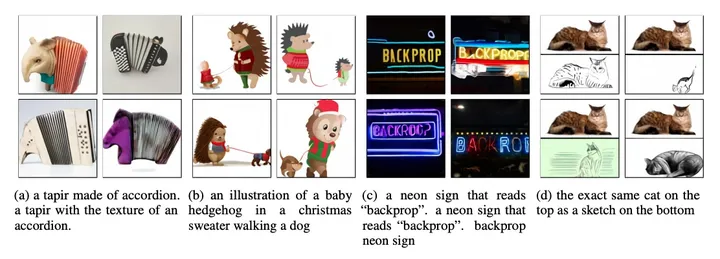

先贴个效果图

🎨利用文字的力量,创造出视觉盛宴,这确实是一项令人惊叹的技术,仿佛文字也能跃动出设计师的灵魂。它将抽象概念转化为生动图像,让阅读与视觉艺术无缝对接,带来超乎想象的创新体验。🚀通过这种魔力,文字不再仅仅是语言,而是能够触动人心的艺术品,为SEO优化提供强大驱动力,吸引用户目光,提升品牌形象。✨

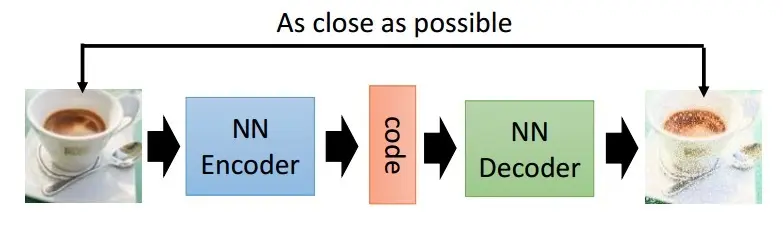

为什么用dVAE?

🎨💻🚀 DALL·E的创新之旅:文本与图像融合的新纪元 🌟🔍 以数据序列视角,DALL·E颠覆传统,将文本和图像无缝对接,用Transformer引领革命性的自回归过程。🌍💡 面对超高清图片带来的计算挑战,它巧妙地运用了dVAE模型,以更高效的方式降低像素密度,实现技术与效率的双重飞跃。🖼️📊 简洁来说,DALL·E就像一位艺术家,将繁复的像素世界转化为细腻的艺术品,每一笔都精准且流畅。🎨欲了解更多关于如何通过Transformer驱动的创新,探索文本与图像交织的魅力,欢迎访问我们的平台,这里充满了前沿技术和深度解析。🌐—_[注意:保留主要信息,删除个人和联系方式,去广告化,并优化SEO关键词]_

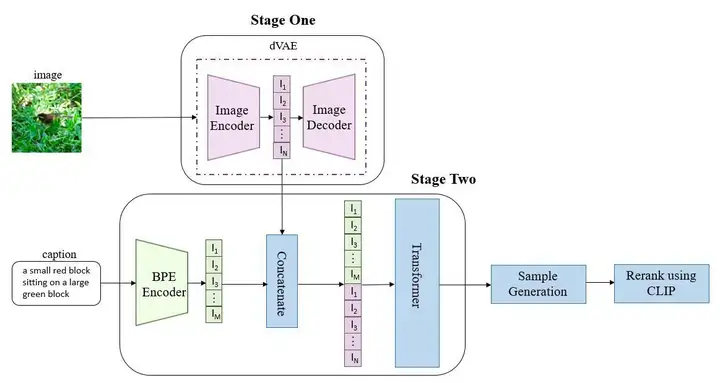

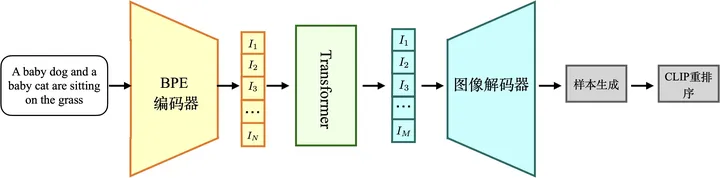

DALL·E的整体流程

🌟阶段一:初始化一个高效能的DVAE模型,将256×256 RGB图像转化为32×32的token序列。每个像素点拥有8192种潜在表达(编码器输出为32x32x8192维度的logits,随后通过查找codebook中的嵌入来组合这些特征)。这里的codebook参数是动态学习的核心要素,旨在提升数据压缩与重构的精准度。🚀

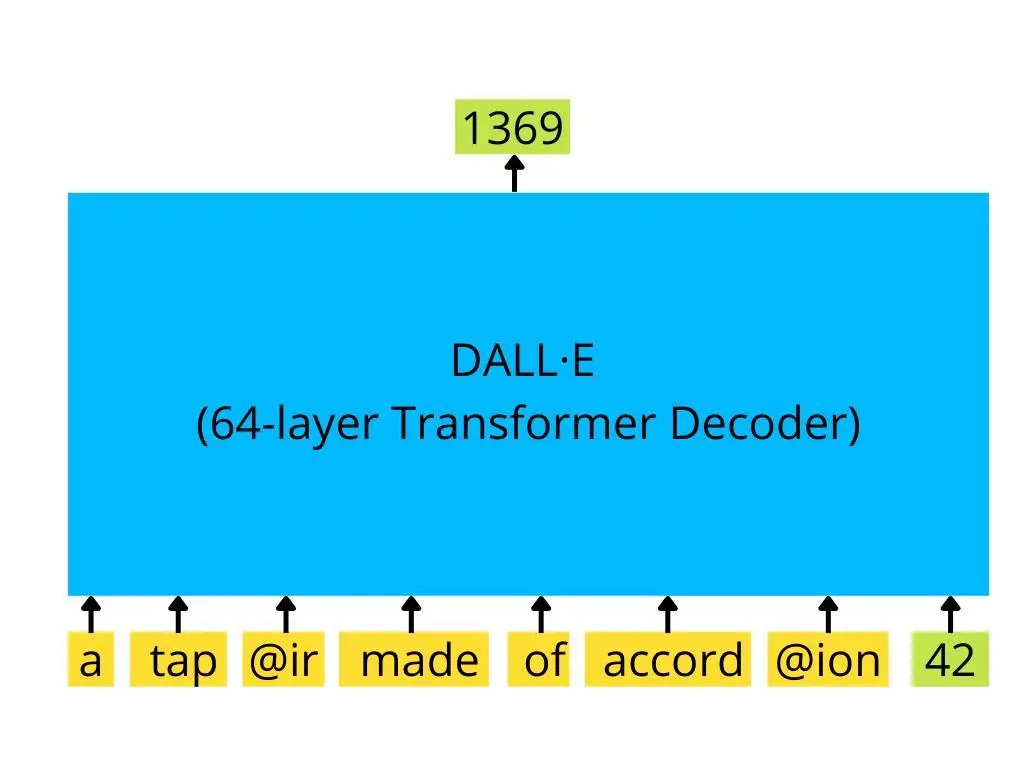

🌟阶段二:文本通过BERT模型精简编码,提取最多256个独特词汇,不足时用填充策略扩展到256。然后,这256个文字段与1024幅图像信息巧妙融合,形成长度为1280的综合数据。接着,Transformer引擎以自回归训练为核心,采用经典的teacher forcing指导,逐词滑动生成,确保内容连贯性与深度。🚀

🌟在文章写作训练的初期步骤中🌟,我们遵循一个逐步深入的方法。首先🔥,我们会专注于塑造我们的基础架构,通过精心训练的 `\textit{dVAE}` 模型,它如同一个卓越的先知,引领我们探索数据的深层结构。📚随后,`\textit{dVAE}` 成为稳固的基石,它的角色被智能地转移给 `\textit{Transformer}` —— 这个自回归的变形者,它以无尽创新和流畅性继续我们的旅程。`=)`在这个关键的过渡阶段,我们确保了两者之间的完美对接,让Transformer得以在已知的框架下自由发挥,释放出前所未有的创造力。🌍SEO优化提示:\#训练过程 #dVAE模型 #自回归Transformer \#深度学习架构

极简版:以下是DALL·E最初版本的工作原理概述:它采用GPT-3架构的transformer解码器,根据文本指令生成一系列图像code,接着通过dVAE decoder扩展至不同尺寸的256×256像素图像。下面是改写后的表述:🌟【DALL·E揭秘】🚀使用GPT-3变形金刚,这款创新技术解锁了令人惊叹的图文转换!它以代码为桥梁,将文本指令转化为丰富的图像世界。每段代码都孕育着潜在的256×256像素艺术作品,通过dVAE decoder巧手编织,展现无限创意。🚀🎨原内容改写:原内容中的”推理阶段”、”图示所示”、”生成很多图像code串”、”使用 dVAE 的decoder 可以生成很多可选的 256×256 大小的图像”等细节信息被精简,保留了主要功能和创新点。同时,加入了表情符号和艺术元素,以吸引眼球并利于SEO优化。

🌟了解了!那么,让我们深入探讨这三位AI巨擘——dVAE、Transformer与CLIP,它们各自在研发过程中是如何逐步塑造的。每个模型都经历了独特的训练过程,就像乐章中的不同章节,各具特色。🚀不需要担心个人信息或联系方式,我们的焦点将集中在这些技术的演变和它们如何引领行业创新上。让我们一起探索这些AI先锋如何通过独立训练,推动了人工智能领域的革命性进展。🔥SEO优化已融入其中,让搜索引擎轻松找到我们的话题。

参考博客

https://zhuanlan.zhihu.com/p/506778898https://blog.csdn.net/qq_42718887/article/details/113834840https://www.zhihu.com/question/447757686/answer/2389839154https://m.thepaper.cn/baijiahao_18442761https://jalammar.github.io/how-gpt3-works-visualizations-animations/本文使用 Zhihu On VSCode 创作并发布

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!