国产“Sora”亮相中关村,文生视频相关个股有哪些

就在昨日,我国人工智能大模型领域又迎来重大突破,AGI的真正连锁反应或将从视频开始。 4月27日上午,“2024中关村论坛-未来人工智能先锋论坛”在北京正式举办,本次平行论坛由科学技术部、北京市人民政府主办,旨在进一步探讨“语言大模型”、“多模态大模型”、“具身智能”等新一代人工智能关键技术与应用的创新。 国产AI视频斩获新进展,中国版“Sora”闪亮登场 就在此次论坛会议上,国内首个纯自研Sora级视频大模型Vidu正式发布。该模型由北京生数科技联合清华大学共同研发,是我国首个长时长、高一致性、高动态性视频大模型。Vidu的发布,表明我国在视频大模型领域已初步具备对标Sora的能力,标志着我国全面进入视频大模型自研时代。 据介绍,Vidu采用研发团队原创的架构U-ViT,支持一键生成长达16秒、分辨率高达1080P的高清视频内容,不仅能模拟真实物理世界,还拥有丰富想象力,具备多镜头生成、时空一致性高等特点。 值得注意的是,与Sora相比,Vidu可以生成特有的中国元素,例如熊猫、龙等。 不少业内人士认为,尽管目前Vidu生成视频的能力只有16秒,距离Sora宣称的还有一定差距,但这显然是训练量不足导致的,Vidu现在的成果表明技术方向是正确的。仅从视频效果和发布时间来看,Vidu已超出了大部人的预期,未来随着在算力、时长等方向上的延伸和突破,Vidu有望为我们带来更多惊喜。 文生视频时代悄然降临,部分行业或将加速变革 此前的2月16日,OpenAI的文字生成视频模型–Sora首次面世。该模型可以根据所输入的prompt(提示词),直接输出最高长达60秒的视频,并且包含高度细致的背景、复杂的多角度镜头,以及富有情感的多个角色。 当时Sora发布的生成视频,无论从人物动作还是场景表现上看,都无比贴近现实。如果不告诉观看者视频是由AI生成的,谁又能辨别出来呢? 这个能够快速且优质地将文字描述转化为引人入胜视频的AI工具,不仅仅代表着技术上的一次巨大飞跃,也预示着我们熟悉的许多行业即将面临一场革命。 有关统计数据显示,目前,全球有超过60亿人口是视频工具和短视频的用户,而其中与视频产业相关的从业者可能已经超过了将近10亿人,占到了全球总人口的13%到14%,这些从业者涵盖了影视行业、短视频行业等诸多我们日常触手可及的各种视频展示领域。 对于影视行业来说,AI视频模型的出现,将极大地降低拍摄剧集的门槛。 做了20年影视导演的某位业内人士,看到AI视频后说的第一句话是“要变天了”,第二句话是“我直到今天才庆幸自己是个导演”。 令从业者发此感叹,主要是因为现在的影视行业,分工极其精细,很多工种和里面的从业者都是阶段式配合,可以说一个环节掉链子,整个戏就可能功亏一篑。而如果AI视频按照现在的速度发展下去,未来至少很多简单的镜头、群演、灯光布景等,都可以用AI去完成了。 而对于短视频行业来说,AI视频生成模型的陆续发布,无疑将令行业竞争进一步加剧。 在全球范围内,无论是中国的抖音、快手、B站和小红书等平台,还是国际版的TikTok,短视频内容消费正处于前所未有的高峰。而随着AI模型的出现,用户现在能够迅速制作出各种类型的视频内容,未来稀缺的不再将是视频拍摄或者剪辑的能力,只要拥有独特的创意,便可轻松入局,行业本就激烈的竞争可能进一步加剧。 文生视频热潮之下,国内哪些上市公司已布局? 文生视频作为AI领域的新兴热点概念,此前曾受到市场资金的“追捧”。2月19日,在Sora的催化之下,诸多概念股迅速升温,部分公司当日股价呈现“20cm涨停”。 而本次Vidu视频生成模型的隆重推出,是否会进一步带动相关概念股股价上涨呢?让我们拭目以待,周一开盘见分晓。 据览富财经网不完全统计,目前A股市场中涉及文生视频相关概念的,共有12家公司,其中不少公司都在积极推进相关业务。

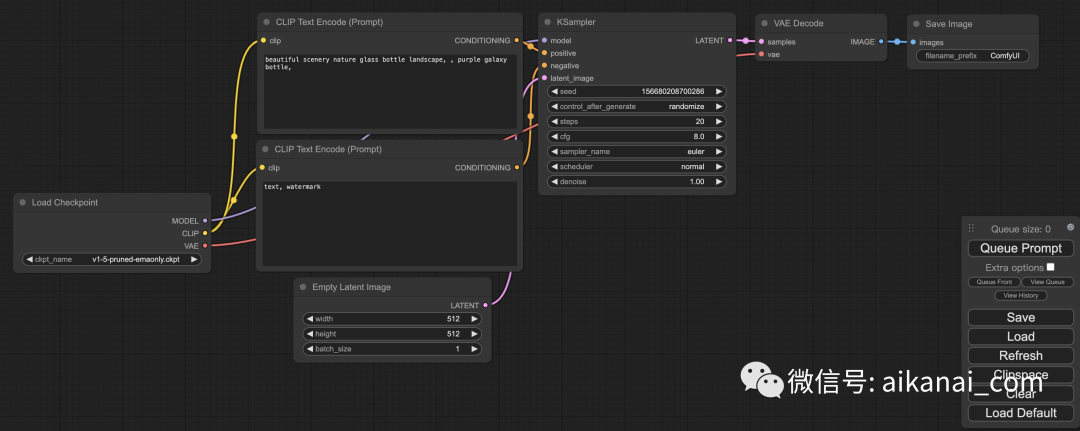

AIGC&人物生成

AIGC&人物生成