文章主题:欧阳宏宇, 国产人工智能, AIGC工具, 文本生成视频

封面新闻记者 欧阳宏宇

国产人工智能带来的魔性作画已经让你审美疲劳了吗?现在,中国造的文字生成视频AIGC工具又来了。

🚀 在谷歌的Imagen和Meta的视频制作技术之后,我国阿里达摩院也最近推出了一款名为“文本生成视频大模型”的创新产品,并在开源模型平台上进行了悄然测试。

这个模型是由三个子网络组成的,分别是文本特征提取、文本特征到视频隐空间扩散模型以及视频隐空间到视频视觉空间的模型,整个模型的参数数量大约为17亿。此外,它还支持英语输入。扩散模型采用了Unet3D的结构,这个结构通过不断从含有纯高斯噪声的视频中迭代去噪,从而实现了视频生成的功能。

简而言之,“给人工智能一段话,就能还你一段视频”;言下之意,使用AI,你也可以变成电影人。

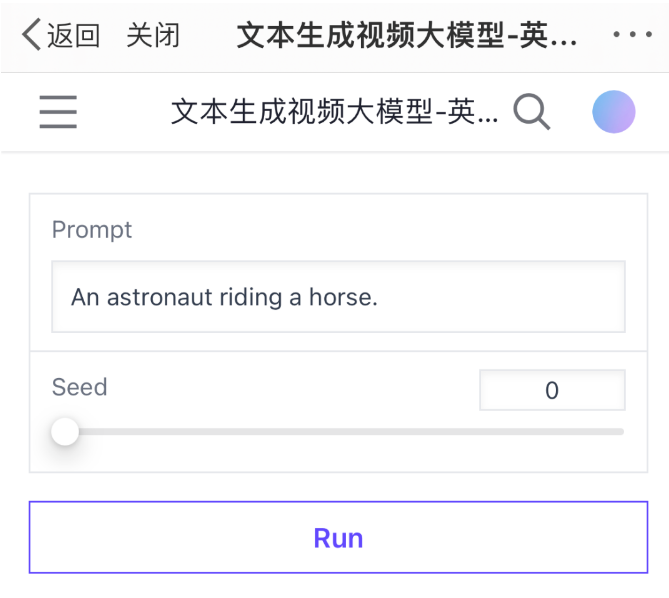

想要知道这款我国自主研发的AI文生视频产品的实际表现如何吗?我们进行了详细的体验和测试,结果如下:该产品的提示词输入只支持英文,视频生成的速度在每分钟1到4分钟之间,生成后会在屏幕上显示一段2秒的视频。生成的视频内容丰富多样,画面炫酷,视觉效果良好,但需要注意的是,它并不包含音轨,偶尔会有跳帧的现象。然而,如果在输入的关键词偏离科学和常识的领域,生成的视频画风可能会开始走偏。

重播

00:00

/

00:00

直播

所生成视频时长为2秒

基本符合逻辑与经验规则

记者首先选择了一些符合日常生活经验和常识的内容。话不多说,直接看效果:

熊猫吃竹子

一名男骑手骑马

大雨中走路的人

经过测试,我们发现当前生成的视频时长大约为2秒,视频的尺寸为256×256,生成等待时间在1分多钟至4分多钟之间。值得注意的是,视频中的细节表现非常出色,如背景中散落的竹叶、逐渐远离的灌木以及卷起大雨的狂风等情景都得到了很好的呈现。

在”一位男骑士骑马”的影片中,我们注意到有跳帧的现象:画面中原本向画面右侧行进的马匹突然改变方向,朝画面的深处前进,然而,马匹后半部分仍保持向右侧移动的状态。考虑到这个大型模型刚上线不久,这种现象也可以理解。😎

根据文本关键词做视频

只是画风有点怪异

想象一下,如果我们给大型人工智能模型输入一些与现实生活不符的体验或一些抽象的描绘,会发生什么情况呢?坦率地说,一旦见证了这样的成果,我相信它会在任何社交平台上引起轰动。

两头大象在厨房忙着做饭

说实话,这视频人家做的没毛病:有大象、在厨房,虽然做的什么不太看得出来,但为了烹调站到灶台上的大象,显然已经很拼了。

贵妃醉酒

这个就更厉害了,很有复古文艺风。

再说说这贵妃,看起来雍容华贵又不失仪表端庄。结合常识来说,两旁的侍女梳的发髻就很像初唐时在宫人中很流行的半翻髻;站在中间的贵妃的发饰则很像盛唐开元年间的双鬟望仙髻……就这个对中国文化的理解就已经很让人佩服。

但是接下来的画风,就有点奇怪了。比如这个……

楚霸王在摩天大楼跳舞

这段视频看起来则是一部科幻片。

摩天大楼像是电影《盗梦空间》里的场景。另外,楚霸王项羽被塑造成了一个像外星人一样的生物,让人想起了一个动漫人物。

如果再增加一些难度,把一些不可能相关的事物联系在一起:

美丽的夏日热带海滩上,一只巨龙在吃冰激凌

这段视频,AI直接返回了一段灾难片:夏日海滩上,绿色的怪兽带着它的幼仔登上海滩觅食……给人一种异兽吞噬页游的既视感。

AI视频并非不合常识

或因数据量影响了结果

看起来,AI好像只是在根据文本描述进行要素的堆砌,几乎不考虑常识和逻辑。

那究竟是否如此?记者随后测试了,让不同的人物或事物在同一个场景下做同样的事,让AI根据“人\香蕉\猫拿着遥控器在看电视”分别生成视频,来看看又会有怎样的结果。

人拿着遥控器在看电视

猫拿着遥控器在看电视

香蕉拿着遥控器在看电视

根据返回的视频可以看到,AI生成的视频仍然是有逻辑和常识可依的。比如,人可以用手拿着遥控器,猫可以用爪子拨弄遥控器;而香蕉则不可能有手或者爪子操作遥控器,只能出现在电视画面中。出现这样的情况或许是可供AI选用的高质量数据不多,只能从现有数据中选取;而这些现有数据则是符合常识的。

文生视频尚待发展

将成为下游应用的加速器

从本质上讲,视频就是一系列图像,最理想的效果就是用户给出提示词,系统自动生成任何风格的对应视频。

根据谷歌此前发布的论文,视频生成框架是七个子视频扩散模型的级联,它们相应执行文本条件视频生成、空间超分辨率和时间超分辨率。借助整个级联,能够以每秒 24 帧的速度生成128帧1280×768的高清视频。

但在实际情况中,生成一个连贯的长视频并没有那么容易。因为在这项任务中,可用的高质量数据非常少,而且任务本身的计算需求又很大。因此,从目前此类模型生成视频的等待时间,画面的真实度、清晰度以及长度等各方面来看,距离产出令人满意的视频还有很大距离。

此外,文本的完整性也是左右文本生成视频迭代的一个瓶颈。有研究显示,像之前那种用于图像生成的简短文本通常不足以提供对视频的完整描述,视频所需要的是一系列文本或故事。研究人员表示,基于故事的条件视频生成之前从未被探索过。

不过,文本生成视频已具备巨大的市场潜力。有研报显示,从头生成视频,无需于其他视频素材,这标志着所有用户无需视频制作技巧,均可以参与到AI视频的创作中来,也标志着AIGC正式迈入了视频时代。

国盛证券表示,随着全民加入AI视频创作,算力需求将会成为更加重要的资源。在未来,算力将成为决定内容质量与商业竞争力的关键因素,即“算力即权力”。同时,AI视频的放量也将会改变目前如电商直播、产品广告、影视制作等多个行业的生态,下游应用的加速时刻也将到来。

【如果您有新闻线索,欢迎向我们报料,一经采纳有费用酬谢。报料微信关注:ihxdsb,报料QQ:3386405712】

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!